13 Juin 2016 : Nouveaux résultats du projet CLOUD (CERN).

Ainsi que des articles récents sur les feux de forêts, le Gulf Stream et les fortes pluies.

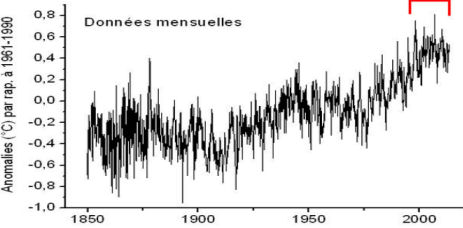

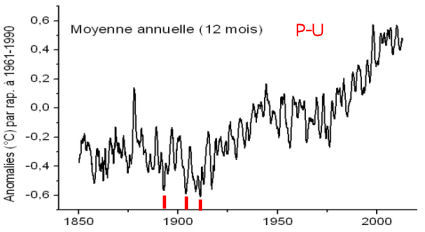

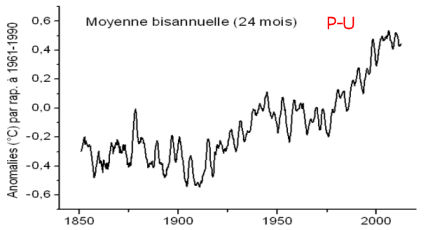

Je reçois fréquemment des courriers de lecteurs(trices) qui s'interrogent au sujet des progrès du projet CLOUD entrepris au CERN de Genève à partir de 2010. Ce projet de grande envergure était initialement destiné à tester la théorie (ou hypothèse) de Svensmark et al. qui attribue un rôle important au rayonnement cosmique pour la constitution des nuages - un des éléments déterminants du climat - et que j'avais évoquée dans cette page, de même qu'ici et dans les billets suivants, sur la même page. Outre le test de l'hypothèse de Svensmark, ce vaste projet international était plus généralement destiné à analyser, en détail, les processus de formation des nuages via la micro-physico-chimie de la nucléation (processus de croissance des noyaux de condensation de la vapeur d'eau).

Car, aussi étonnant que cela puisse paraître, on ne sait (savait) pas encore exactement comment se forment les nuages à partir de la vapeur d'eau contenue dans l'atmosphère.

Nos lecteurs(trices) doivent se souvenir que, comme tous les projets du CERN de Genève, CLOUD relève d'expériences particulièrement "lourdes" qui font appel à des technologies aussi coûteuses que délicates, à la disponibilité intermittente "des temps de faisceau" des sources à haute énergie etc. D'autre part, le CERN se fait un point d'honneur de ne publier que des résultats et des observations dûment reproductibles et soigneusement vérifiées, ne serait-ce que parce que ces expériences sont très difficiles (sinon impossibles) à dupliquer dans d'autres laboratoires. Tout cela entraîne des délais de publications très importants et justifie que les rapports et articles ne paraissent qu'après mûre réflexion et après de longs intervalles de temps.

En bref, le statu-quo ante qui résultait, en 2011, des travaux de CLOUD menés au CERN, avant la publication des articles que je vais vous présenter ci-dessous était le suivant :

-Les tests de l'appareillage complet étaient satisfaisants. Il s'agit d'une vaste chambre d'expérience (de la taille d'un autobus) dans laquelle on peut reconstituer parfaitement et de manière contrôlée la complexité de la composition de l'atmosphère terrestre réelle. L'appareillage sophistiqué qui lui est associé permet de suivre en détail, tous les paramètres importants et en particulier la composition et la taille des noyaux de nucléation propres à la formation des nuages.

-Le rôle important joué par l'acide sulfurique dans les processus de nucléation a été confirmé ainsi que l'amplification induite par les rayons cosmiques comme l'avait proposé Svensmark et al.

-Cependant, les expériences et les mesures effectuées, en l'absence d'ions, ne permettaient pas d'expliquer l'abondance et la dynamique de la nucléation et des nuages observées dans les conditions réelles. Il apparaissait nécessaire de trouver une autre voie que celle des "polluants" atmosphériques tels que les composés du soufre et autres minéraux.

- Dès lors, comme je l'avais précisé à l'époque (en fin 2011), l'équipe CLOUD avait décidé d'orienter ses recherches vers l'étude de la possibilité, pour la formation des nuages, de particules ionisées organiques purement biogéniques, naturellement présentes dans l'atmosphère et dont plusieurs expériences préliminaires (mais réalisées en atmosphère bien moins contrôlée) avaient suggéré l'importance.

Dans la suite, je vais vous présenter les derniers résultats du Projet CLOUD publiés tout récemment sous la forme de trois articles parus simultanément dans des revues à fort impact ainsi que les éditoriaux (plus compréhensibles) publiés, à ce sujet dans ces mêmes revues.

Ce billet sera complété par la présentation de quelques articles récents en rapport avec l'actualité, toujours publiés dans des revues scientifiques renommées, qui démentent, preuves à l'appui, les affirmations péremptoires et ultra-alarmistes que l'on a pu entendre ou lire, ici ou là, il y a peu, sur les feux de forêts, sur les fortes pluies et sur le Gulf Stream dont certains nous assuraient, sur la base de données tronquées, qu'il s'affaiblissait dangereusement.

1) Les derniers résultats du Projet CLOUD : Les nuages se forment aussi sous l'action d'ions biogéniques (par exemple issus des arômes émis par les forêts de résineux).

Voici les titres et les références des trois articles publiés récemment par l'équipe du Projet CLOUD :

- "Nucléation induite par des ions de particules purement biogéniques." (dans la revue Nature)

- "Le rôle de composés organiques à faible volatilité dans la croissance des particules dans l'atmosphère." (dans la revue Nature)

- "Formation de nouvelles particules dans la troposphère : Une affaire de chimie et de timing." (dans la revue Science)

Ces articles ont fait l'objet d'analyses éditoriales dans les deux revues Nature et Science. Ces analyses que je vais évoquer ci-dessous, sont nettement plus compréhensibles que les articles originaux qui se révèlent, comme on s'en doute, particulièrement "techniques".

De manière générale, les médias anglophones ont largement fait écho à ces découvertes qui semblent marquer un tournant important dans la compréhension de la micro-physico-chimie conduisant à la formation des nuages et qui viennent, entre autres, confirmer l'hypothèse de Svensmark.

L'article suivant, publié le 25 Mai dans Nature, est cosigné par 70 auteurs relevant de 17 institutions internationales de pratiquement toutes les grandes nations scientifiques (sauf le France qui n'a pas souhaité faire partie du projet CLOUD. Néanmoins, un français, Ortega de l'ONERA est co-auteur de ces études).

Voici le fac-simile de la présentation de cet article accompagné d'une traduction en français de son résumé :

Nucléation induite par les ions de particules d'origine purement biogénique.

Publié le 25 Mai 2016

Jasper Kirby et al (69 autres auteurs).

Résumé :

Les aérosols atmosphériques dont on pense qu'ils sont importants pour ce qui concerne le forçage radiatif anthropique sont cependant restés largement incompris. De manière globale, environ la moitié des noyaux de condensation qui forment les nuages résulte de la nucléation des vapeurs atmosphériques. On pensait que l'acide sulfurique était un ingrédient essentiel pour initier la plupart des formations de particules dans l'atmosphère et que les ions n'y jouaient qu'un rôle mineur. Cependant, des recherches en laboratoire ont montré la formation de particules organiques en l'absence d'addition intentionnelle d'acide sulfurique, bien qu'une contamination ne pouvait être exclue.

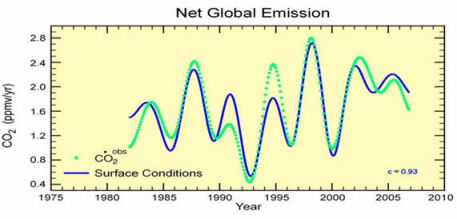

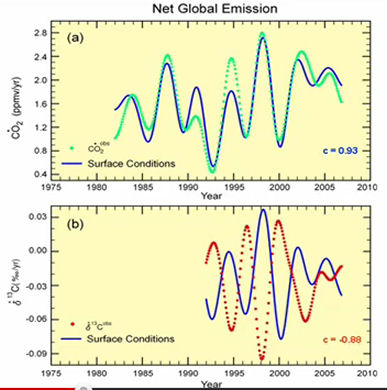

Dans cet article nous présentons des preuves de la formation de particules aérosols à partir de vapeurs organiques fortement oxydées en l'absence d'acide sulfurique dans une vaste chambre dans laquelle règne les conditions de l'atmosphère. Les molécules hautement oxygénées (HOMs) sont produites par ozonolyse de l'alpha-pinéne. Nous observons que les ions résultants des rayons cosmiques Galactiques augmentent la nucléation d'un à deux ordres de grandeur par rapport à la nucléation en situation neutre. [NdT : C'est l'effet anticipé autrefois par Svensmark et al.]. Nos découvertes expérimentales sont étayées par des calculs de chimie quantique des énergies de liaisons des amas des HOMs représentatifs. La nucléation induite par les ions de particules d'origine purement organique constitue une source potentielle largement répandue de particules aérosols dans l'environnement terrestre présentant une faible pollution par l'acide sulfurique. |

Voici maintenant, une traduction en français d'extraits de l'analyse publiée dans la revue Science au sujet de l'article précédent. A gauche le fac-similé de l'article original et à droite une traduction en français. Les caractères engraissés sont le fait de PU.

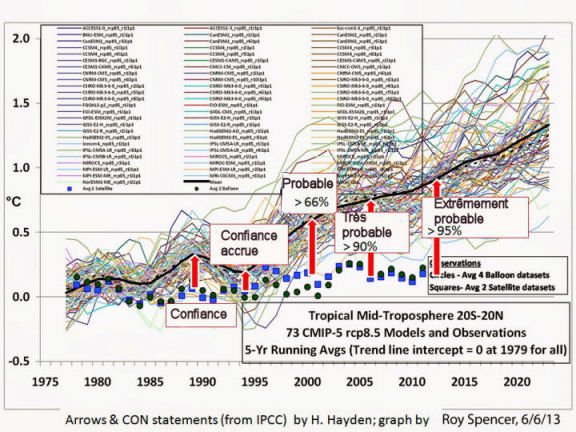

Le climat de la Terre pourrait ne pas se réchauffer aussi vite qu'on le pensait, suggèrent de nouvelles études sur les nuages.

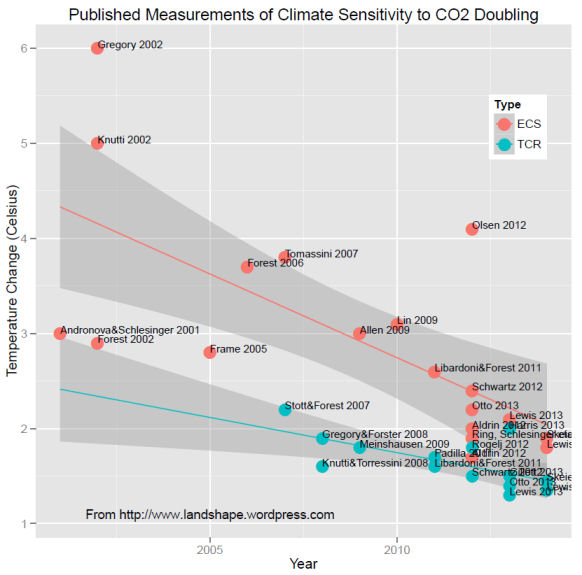

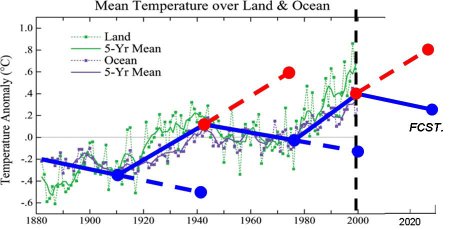

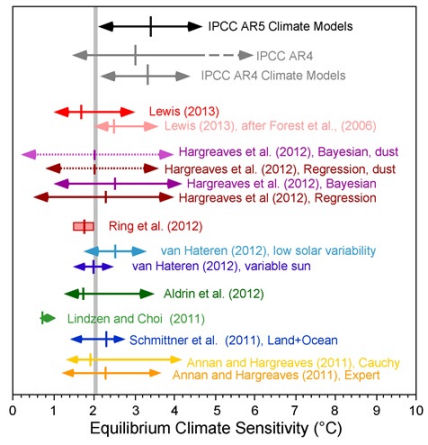

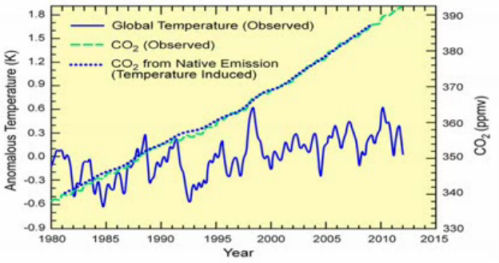

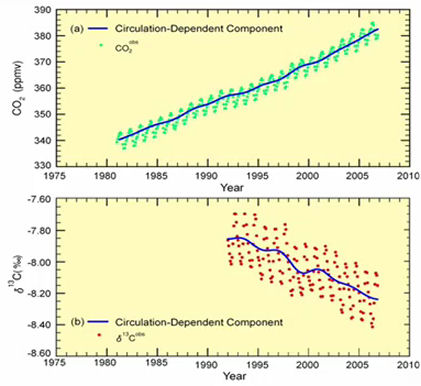

Les nuages doivent, pour se former, se condenser autour de petites particules appelées aérosols et les aérosols résultant de la pollution anthropique - essentiellement sous la forme d'acide sulfurique - ont contribué à rendre les cieux plus nuageux. C'est pour cette raison que les scientifiques ont généralement supposé qu'autrefois, les cieux de la planète étaient plus ensoleillés qu'ils ne le sont à présent. Mais, de nos jours, trois nouvelles études montrent comment des émissions naturelles de gaz issues des arbres peuvent également constituer des semences pour les nuages. Ces résultats ne pointent pas seulement vers un passé plus nuageux mais ils indiquent aussi un futur potentiellement plus frais : Si le climat de la Terre est moins sensible à l'augmentation du dioxyde de carbone (CO2) ainsi que le suggère cette étude, les températures du futur pourraient ne pas augmenter aussi vite que cela a été prédit.

“On a longtemps pensé que l'acide sulfurique était réellement l'acteur clef [de la formation des nuages] " dit un chimiste de l'atmosphère, Chris Cappa de l'Université de Californie, Davis, qui n'était pas impliqué dans cette recherche. Les études "montrent de façon plutôt convaincantes que nous n'avons pas besoin d'acide sulfurique pour permettre à de nouvelles particules de grossir".

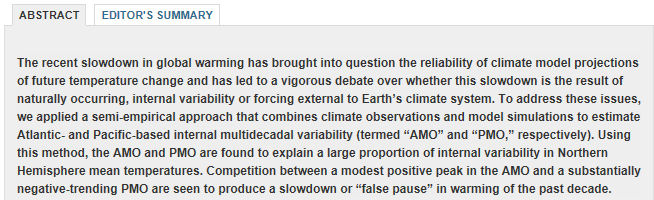

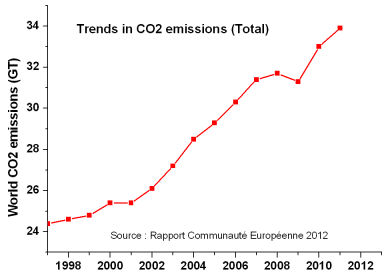

Les scientifiques qui sont d'accord avec le fait que le CO2 et d'autres gaz réchauffent la Terre, sont en désaccord profond au sujet de la sensibilité du climat de la planète du fait de ces changements. Un des points de contentieux concerne l'effet du dioxyde de soufre, un polluant dont la concentration a augmenté presque de 7 fois durant l'époque moderne. Le dioxyde de soufre réagit avec l'oxygène et l'eau pour former de l'acide sulfurique qui contribue à la formation des particules aérosols qui servent de semences pour les gouttes d'eau. Comme les nuages réfléchissent la lumière du soleil vers l'espace, toute augmentation des nuages pourrait avoir effacé une fraction du réchauffement dû aux gaz à effet de serre.

De fait, cette nouvelle recherche suggère que le passé peut avoir été plus nuageux que les scientifiques l'imaginaient. De manière à simuler les conditions de l'atmosphère d'autrefois, un groupe de chercheurs a utilisé le projet CLOUD (Cosmics Leaving Outdoor Droplets) qui consiste en une chambre à atmosphère contrôlée au CERN, le centre européen de recherche sur les particules à Genève, en Suisse. Presque aussi grande qu'un autobus, la chambre e été remplie d'un air produit de manière synthétique qui permet de conserver des conditions chimiques contrôlées avec précision. Jasper Kirkby qui est un physicien des particules au CERN et ses collègues ont introduit un mélange d'oxydants naturels présents dans l'air ainsi qu'un hydrocarbure organique émis par des conifères. L'hydrocarbure a été rapidement oxydé. Le seul autre apport extérieur rentrant dans la chambre ont été des rayons cosmiques issus de l'espace qui ont participé à l'agglomération des particules en aérosol. L'acide sulfurique n'était pas nécessaire. De fait, même quand les chercheurs ont introduit de l'acide sulfurique dans la chambre tel qu'on pourrait en trouver dans un air non pollué, le taux de formation des aérosols n'a pas été affecté. Dans un second article du projet CLOUD publié simultanément dans Nature, les chercheurs ont montré que les mêmes particules oxydées pouvaient rapidement croître jusqu'à des tailles suffisamment importantes pour amorcer la formation des gouttes d'eau des nuages.[suite ci-dessous] ... |

Voici à présent, à gauche, le fac-similé du second article publié dans Science par une autre équipe de chercheurs dont plusieurs participent aussi au Projet CLOUD. Cette fois-ci, il s'agit d'une expérience sur le terrain, en haute altitude. Ses observations confirment les résultats du Projet CLOUD des deux articles publiés dans Nature.

Cette expérience est expliquée dans la suite du texte de l'éditorial de Science dont voici la suite ( à droite).

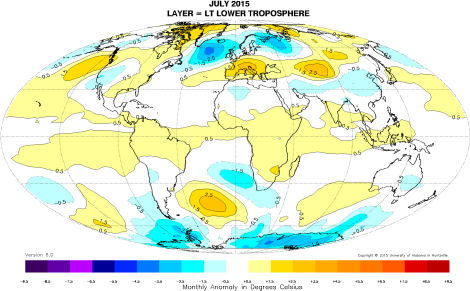

...( Suite) A la recherche d'un environnement atmosphérique préservé, un second groupe de chercheurs a fait des expériences sur la formation des aérosols atmosphériques dans la station de recherche de haute altitude du Jungfraujoch située à 3500 m d'altitude dans les Alpes suisse, afin de confirmer que ces processus se produisent effectivement dans la nature. Durant une année complète, ils ont mesuré les variations de concentration des molécules d'acide sulfurique et des molécules organiques dans l'air. Ils ont trouvé que plus d'aérosols étaient formés quand il y avait plus de molécules organiques présentes dans l'air et - de manière cruciale - ils ont observé la formation de particules organiques en l'absence d'acide sulfurique. Ils ont utilisé exactement les mêmes instruments que ceux de CLOUD pour analyser les aérosols. "Les amas étaient constitués essentiellement de particules organiques" dit le chimiste de l'atmosphère, Federico Bianchi de l'Institut Paul Scherrer de Villigen en Suisse, lequel a dirigé l'équipe de chercheurs qui a travaillé au Jungfraujoch et dont les résultats sont publiés aujourd'hui dans Science.

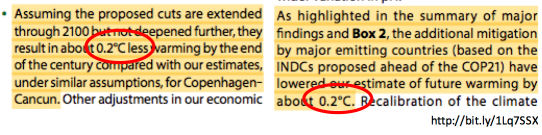

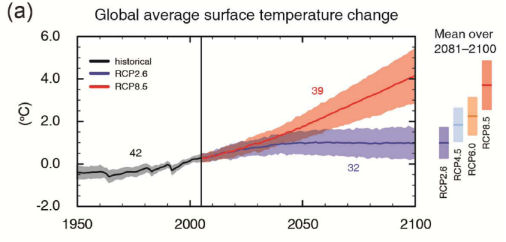

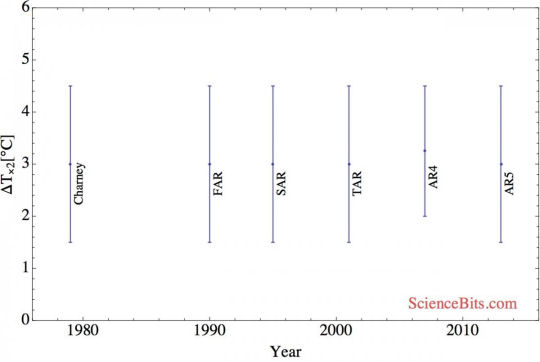

Tous les chercheurs insistent sur le fait que l'acide sulfurique est encore un contributeur essentiel à la formation des nuages, de nos jours, sur Terre. " De nos ,jours, la voie basée sur les végétaux est beaucoup moins importante que c'était le cas dans la situation pré-industrielle" explique Kirkby. Mais il est cependant crucial que ces résultats signifient que les modélisateurs du climat ne peuvent supposer que le passé était beaucoup moins nuageux simplement parce qu'il y avait moins de dioxyde de soufre. Si la couverture nuageuse des temps anciens était proche de ce qu'elle est de nos jours, l'augmentation du refroidissement résultant de la pollution humaine pourrait être plus petite - ce qui signifie que la Terre ne se réchauffait pas autant qu'on le croyait en réponse aux gaz à effet de serre seuls. En d'autres termes, la Terre est moins sensible aux gaz à effet de serre qu'on le pensait auparavant et elle pourrait moins se réchauffer du fait des futures émissions de carbone, dit Urs Baltensperger du Paul Scherrer Institute, qui est auteur des trois articles. Il dit que les meilleures estimations actuelles des températures futures peuvent encore être crédibles mais que "les valeurs les plus élevées deviennent improbables".

Les chercheurs travaillent à présent sur une estimation plus précise de conséquences du nouveau processus sur les prédictions du climat futur de la Terre. |

Nature News a également publié un article au sujet de ces publications. Voici le fac-simile de la présentation à gauche et une traduction de quelques extraits de ce texte qui est très proche de celui qui est paru dans Science et que vous avez vu ci-dessus. Il est intitulé " ".

"La surprenante découverte au sujet de l'ensemencement des nuages pourrait améliorer les prédictions climatiques.

Une molécule fabriquée par les arbres peut ensemencer les nuages, ce qui suggère que les époques pré-industrielles étaient moins ensoleillées que ce que l'on pensait."

Ces découvertes vont à l'encontre d'une supposition qui est que l'acide sulfurique polluant est indispensable pour assurer un certain mode de formation des nuages - et elles suggèrent que les prédictions climatiques peuvent avoir sous-estimé le rôle qu'ont joué les nuages dans la constitution du climat pré-industriel.

Si les résultats de ces expériences sont avérés, les prédictions du futur changement climatique devront les prendre en compte dit Reto Knutti, un modélisateur du climat de l'Institut Fédéral de Technologie Suisse. Depuis plus de 20 ans, les nuages ont été la plus grande source des incertitudes dans la compréhension de la manière dont les émissions anthropiques affectent l'atmosphère, dit-il. [...]

En plus de venir contribuer aux prédictions climatiques, ces découvertes ont une autre implication potentielle, dit un scientifique de l'atmosphère, Bjorn Stevens du Max Planck Institute pour la Météorologie de Hambourg en Allemagne. Certains scientifiques ont averti que les mesures prises pour éliminer le dioxyde de soufre des centrales à charbon pourraient supprimer l'effet bénéfique refroidissant des nuages et pousser à la hausse le réchauffement climatique, mais ceci est maintenant moins à craindre puisque les arbres peuvent, eux aussi, ensemencer les nuages . "Ce que cela signifie, c'est que nous ne devons pas redouter un air propre" dit Stevens. [...]

Il est également intéressant de spéculer pour savoir si les arbres émettent des composés en partie parce que cela est bénéfique pour eux de fabriquer leur propre climat, dit Kirkby."Ceci touche en fait à l'hypothèse Gaïa" dit-il en se référant à la théorie qui dit que la vie sur Terre tend à se préserver elle-même comme s'il s'agissait d'un seul organisme. " C'est un beau mécanisme que celui qui est utilisé par les arbres pour contrôler leur environnement."

[NdT : Kirkby conclut par cette remarque semi-philosophique. Pour ma part, j'avais évoqué, en 2007, une sorte d'"effet parasol" provoqué par les DMS émis par les phyto-planctons marins de même que la remarquable pruine dont se recouvrent un certain nombre de végétaux, en été, pour limiter leurs pertes hydriques, profitant notamment des vertus de "l'effet Lotus". |

Remarques :

Comme le faisait remarquer Henrik Svensmark lui-même, il faut également savoir qu'il existe des sources de sulfures/sulfates sur la planète qui ne proviennent pas de l'action anthropique (par exemple, les phyto-planctons et les volcans).

Il n'en reste pas moins que cette série d'article des équipes CLOUD, outre qu'elle confirme et prouve la validité de l'hypothèse de Svensmark et al. (cad : que les rayons cosmiques galactiques participent activement à la formation des noyaux de condensation des nuages), constitue un grand pas en avant dans la compréhension de la micro-physico-chimie de la génération des nuages qui sont des déterminants essentiels du climat de la planète.

Les alpha-pinénes utilisées dans ces études, sont d'origine purement organique (biogénique) et ne proviennent pas de la pollution anthropique. Ils résultent des émanations générées par les forêts de conifères et ce sont d'ailleurs eux qui donnent l'odeur caractéristique de leurs sous-bois au point qu'on les a baptisées "arôme".

On peut penser que ces molécules biogéniques ne sont pas les seules molécules organiques d'origine naturelle et facilement oxydables qui contribuent à l'ensemencement des nuages. Par exemple, l'isoprène, très présent dans l'atmosphère et hautement oxydable, serait, peut-être un autre candidat potentiel pour la formation d'aérosols comme indiqué dans cet article publié dans Science (référence communiquée par un expert, lecteur de PU, que je remercie). La contribution de substances purement biogéniques organiques à la génération des nuages remet sérieusement en question le niveau de compréhension de la couverture des nuages de la planète. Et chacun sait que les questions d'ennuagement (et donc d'albedo) constituent une des incertitudes fondamentales des modèles climatiques.

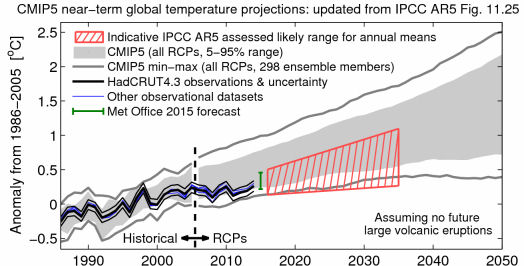

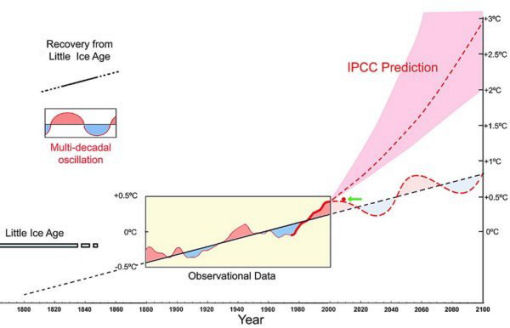

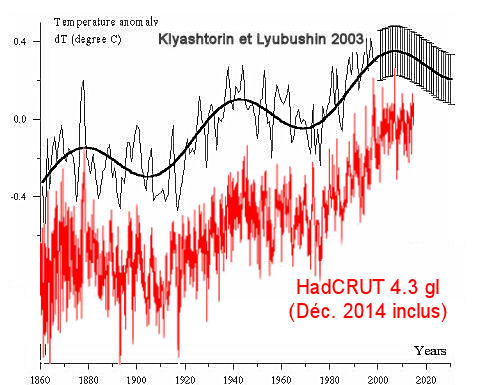

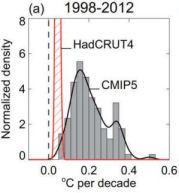

Dans l'état actuel des choses, comme le font remarquer des chercheurs du domaine, il est clair que cette découverte tend à abaisser sérieusement les prévisions les plus élevées du réchauffement de la planète... telles que celles qui ont largement motivé la COP21 où on nous affirmait péremptoirement qu'en matière de science, la "messe est dite" ou "la science est comprise".

Comme on le voit, elle ne l'est pas.

___________________________________________________________________________________

Pour terminer ce (long) billet, nous allons survoler trois sujets qui ont mobilisé récemment l'actualité environnementale ou climatique et dont les médias et les politiques ont fait leurs choux gras durant ces dernières semaines. De fait, par les temps qui courent, tout événement environnemental, météorologique ou connexe, est immédiatement inscrit, par certains, dans le contexte du "réchauffement climatique anthropique et catastrophique". Vous l'avez certainement remarqué. .

Mais comme le savent les lecteurs(trices) de PU, plutôt que de lire les coupures de presse ou écouter les déclarations des politiques, nous préférons nous référer aux sources que constituent les articles scientifiques parus dans les meilleures revues sur ces sujets. Nous allons donc revoir successivement la question des incendies (en relation avec ceux qui ont affecté l'Alberta au Canada), la question du Gulf Stream dont beaucoup se soucient et la question des fortes pluies et des inondations que certains (y compris les politiques les plus éminents) cherchent désespérément à relier au réchauffement anthropique.

2) Y a t-il plus d'incendies de forêts ?

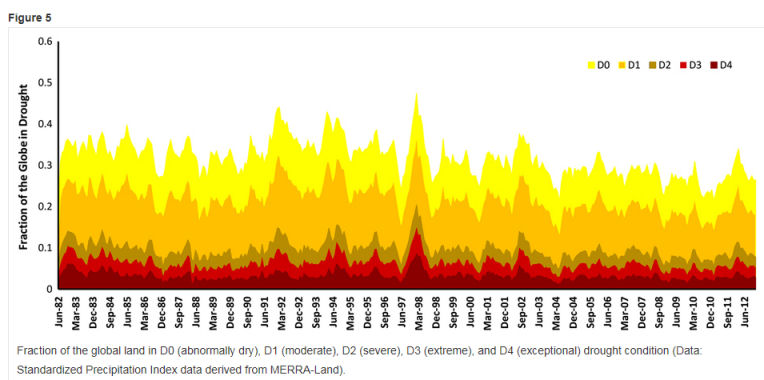

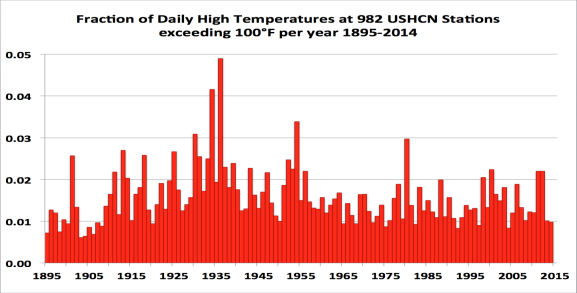

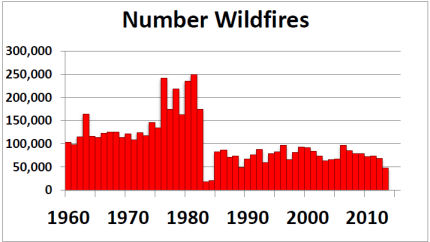

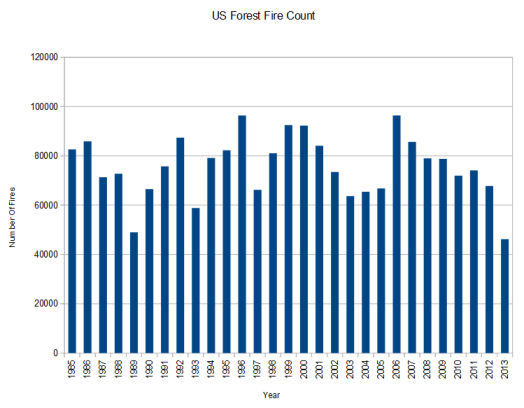

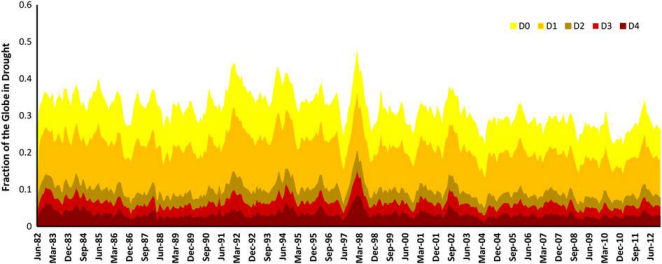

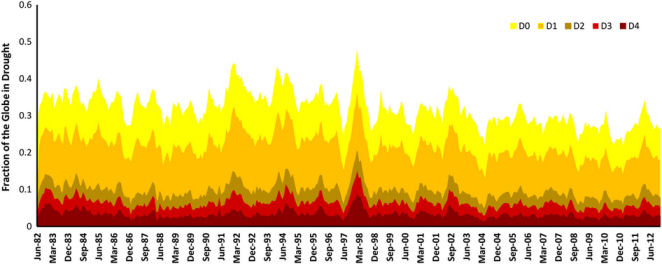

J'ai déjà évoqué cette question, liée aux sécheresses dans les billets précédents. Les statistiques officielles montrent qu'il n'y a aucune tendance détectable dans la violence et la fréquence des incendies au moins dans les zones bien documentées comme les USA. Pour ce qui est des sécheresses, on n'observe aucune tendance depuis des décennies, à l'échelle du globe.

Un article qui traite des incendies à l'échelle du globe et de leur perception est paru le 22 Mai, sous la plume de deux spécialistes reconnus du domaine, dans une vénérable (une des plus anciennes revues au Monde !) et respectable revue anglaise. En voici, ci-dessous, un fac-similé et une traduction du résumé.

Sa référence est :

world. Phil. Trans. R. Soc. B 371: 20150345.

http://dx.doi.org/10.1098/rstb.2015.0345

Cet article est, à l'heure présente, en accès libre.

Tendances globales des feux de forêts et de leurs impacts : Perception contre réalités dans un monde en évolution.

Stefan H. Doerr et Cristina Santin

publié le 26 Mai 2016

Résumé : Les feux de forêts constituent un processus important affectant la surface terrestre et l'atmosphère depuis plus de 350 millions d'années et les sociétés humaine ont coexisté avec les feux depuis leur apparition sur la Terre. Pourtant, beaucoup considèrent que les feux de forêts sont un problème en voie d'accélération, avec une perception largement répandue tout à la fois dans les médias et dans les articles scientifiques d'une augmentation de la fréquence des feux, de leur sévérité et des pertes associées.

Cependant, hormis quelques importantes exceptions, les preuves quantitatives disponibles ne vont pas dans le sens de la perception de ces tendances générales. Au contraire, la surface brûlée sur le globe apparaît avoir globalement décliné durant les dernières décennies et il y a de plus en plus de preuves qu'il y a moins d'incendies dans le paysage global de nos jours qu'au cours des siècles passés. Pour ce qui concerne la sévérité des incendies, il n'existe qu'un nombre limité de données disponibles. Pour l'Ouest des USA, elles indiquent peu de changement global et aussi que les surfaces brûlées par des feux intenses ont décliné en comparaison avec la période précédant l'installation des premiers européens. Les pertes humaines directement liées aux incendies et les pertes économiques ne montrent, elles non plus, aucune tendance claire durant les trois dernières décennies. Les tendances des impacts indirects tels que les problèmes de santé résultant des fumées et des ruptures sociétales, restent insuffisamment quantifiées pour qu'on puisse les prendre en compte. Les prédictions globales d'un accroissement des incendies dans un climat se réchauffant mettent en lumière le besoin pressant d'une coexistence plus soutenable avec les feux. L'évaluation des données présentées dans cet article vise à y contribuer en démontant les idées fausses et à permettre une meilleure compréhension basée sur des informations valides au sujet des réalités des incendies à l'échelle du globe.

Cet article fait partie du numéro spécial sur le thème "Les interactions entre les feux et l'humanité". |

Autrement dit, nos deux experts, se basant sur des données avérées, démontent carrément l'alarmisme ambiant concernant les feux de forêts et les incendies tels que celui qui ont saturé la sphère médiatico-politique durant les récents incendies de l'Alberta qui, pourtant, n'étaient ni les premiers, ni les plus étendus du genre dans cette région du globe. Malheureusement, il est douteux que nos édiles et nos médias jettent un coup d'oeil sur le numéro spécial "les interactions entre le deux et l'humanité" publié par la vénérable revue qui a collationné ces articles.

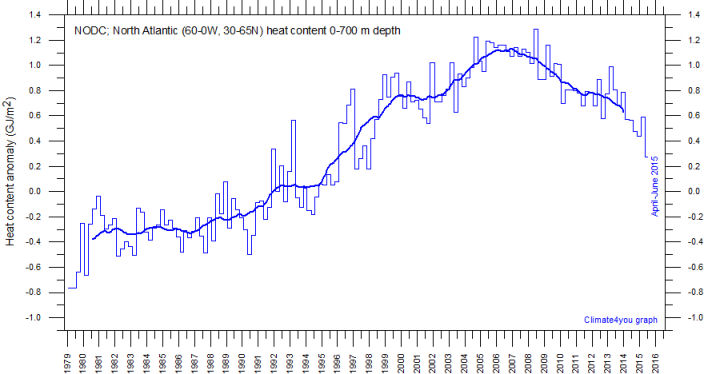

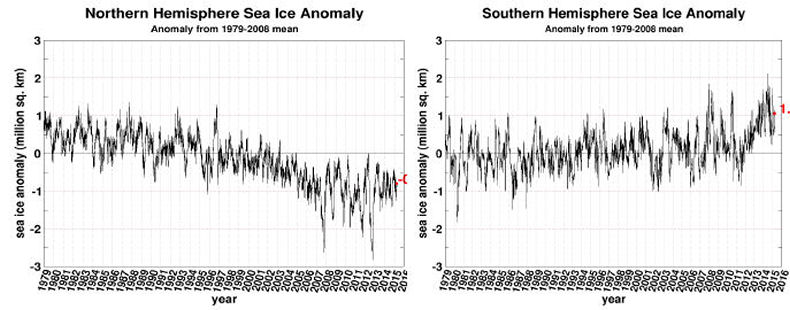

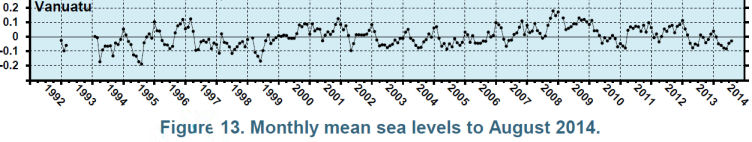

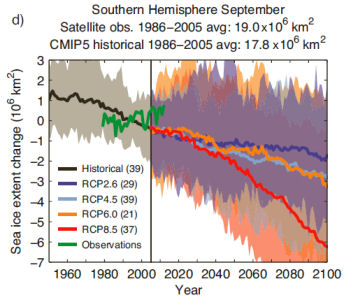

2) Le ralentissement de l'AMOC et donc du Gulf Stream ?

Combien de fois n'avons-nous pas lu ou entendu dire dans les médias ou dans les forums qui fleurissent sur la toile que le "réchauffement climatique anthropique" avait pour conséquence le ralentissement brutal et "catastrophique" voire "l'arrêt définitif" du Gulf Stream ?

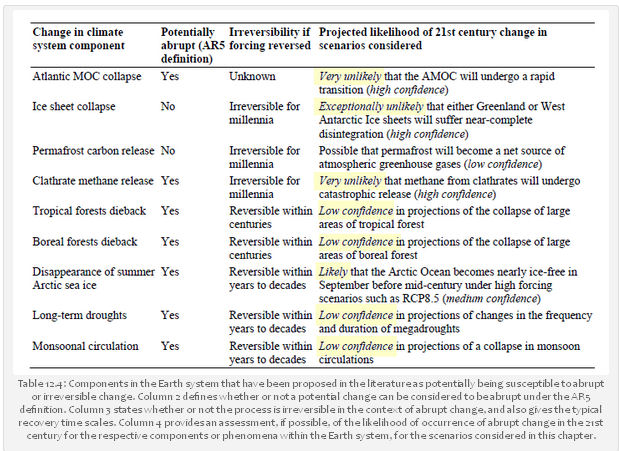

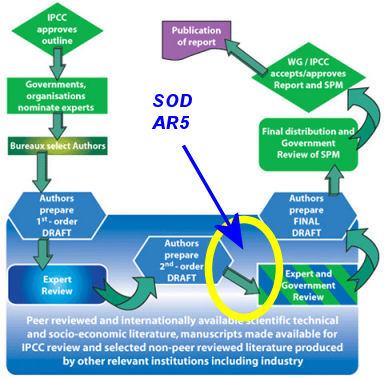

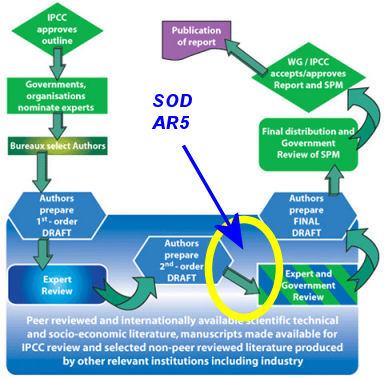

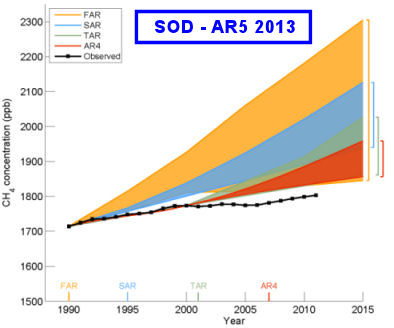

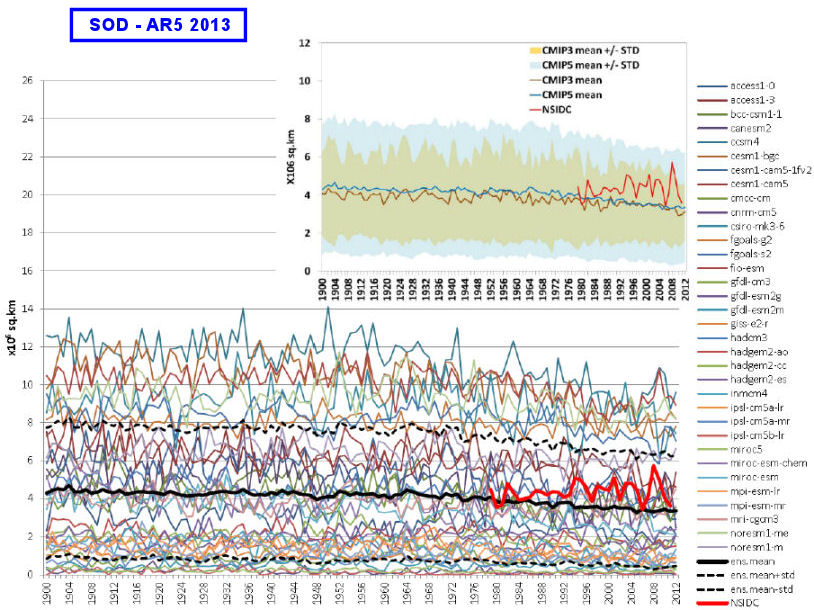

Et ceci en dépit des conclusions du dernier rapport du GIEC, l'AR5 (2013) que, visiblement, personne ne prend la peine de lire. On peut y trouver le diagnostic suivant : "Il est très improbable que l'AMOC (NdT : boucle d'échange thermohaline dont le Gulf-Stream est une branche) subira une transition rapide (Confiance élevée)."

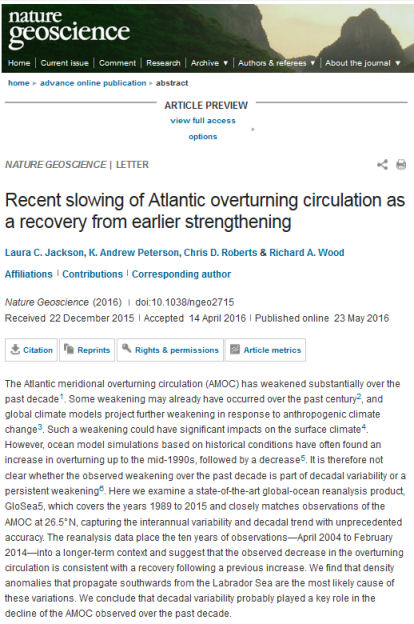

Un article qui est paru en 2015 dans Nature Geosciences (Nature Geoscience (2016) doi:10.1038/ngeo2715), sous la plume de chercheurs du Met Office UK, fait état de progrès dans ce domaine qui contredisent les déclarations alarmistes à ce sujet.

De fait, la conclusion de l'article est que dans l'état actuel de nos connaissances, on observe que les variations de l'AMOC sont très probablement d'origine naturelle. Voici l'article de Nature Geosciences (fac similé à gauche, traduction à droite) qui en fait le constat :

Le récent ralentissement de la circulation méridionale de retour de l'Atlantique vu comme la récupération d'un renforcement antérieur.

Laura C. Jackson et al ( Met Office, UK)

Publié le 23 Mai 2016

Résumé :

La circulation méridienne de prolongementde l'Atlantique (AMOC) s'est affaiblie sensiblement durant la dernière décennie. Un certain affaiblissement s'est peut-être produit durant le siècle précédent et le modèles climatiques du globe projettent un affaiblissement accentué en réponse au changement climatique anthropique. Un tel ralentissement pourrait avoir des impacts significatifs sur le climat qui règne à la surface.

Cependant, des modélisation des océans basées sur les conditions historiques ont souvent observé une augmentation du prolongement jusqu'au milieu des années 1990, suivies par une décroissance.De ce fait, la situation n'est pas clarifiée pour ce qui est de savoir si l'affaiblissement de la dernière décennie résulte d'une variabilité décennale où d'un affaiblissement persistant.

Dans cet article, nous étudions le résultat du modèle

le plus récent de réanalyse des océans du globe, GloSea5, qui recouvre les années 1989 à 2015 et qui s'accorde parfaitement avec les observations de l'AMOC à 26,5°N, rendant compte de la variabilité interannuelle et de la tendance décennale avec une précision jamais atteinte jusque là. La réanalyse replace les dix années d'observations - Avril 2004 à Février 2014 - dans un contexte temporel plus long et elle suggère que la décroissance observée de la circulation de prolongement [NdT : l'AMOC] est cohérente avec une récupération succédant à une augmentation antérieure. Nous trouvons que les anomalies de densité qui se propagent vers le Sud en provenance de la mer du Labrador, constituent la cause la plus probable pour ces variations.

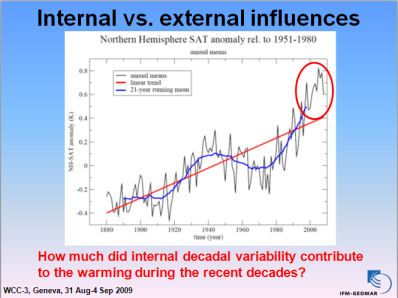

Nous en concluons que la variabilité décennale a probablement joué un rôle clef dans le déclin observé de l'AMOC durant la dernière décennie. |

Autre source : Communiqué du Met Office (UK) sur reporting Climate science.com.

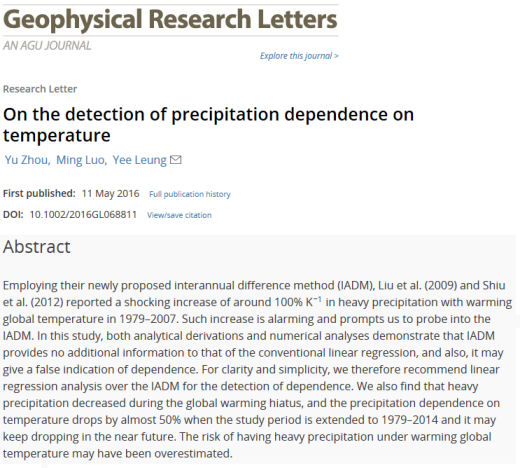

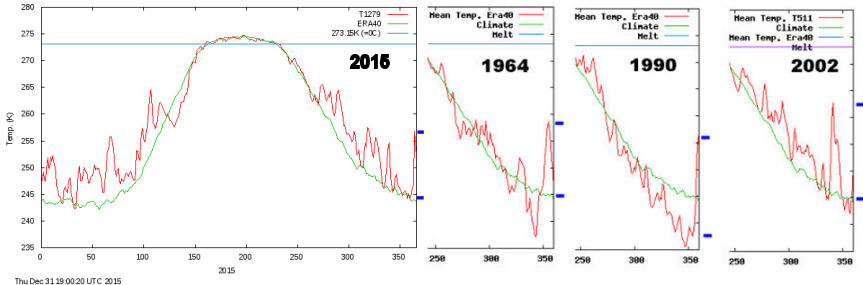

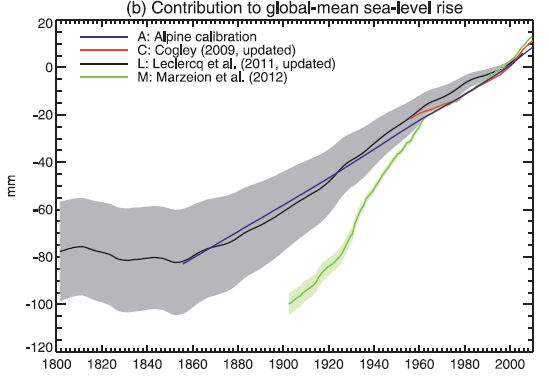

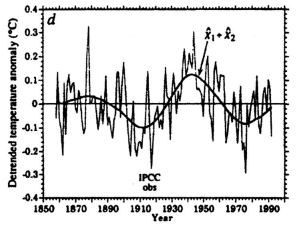

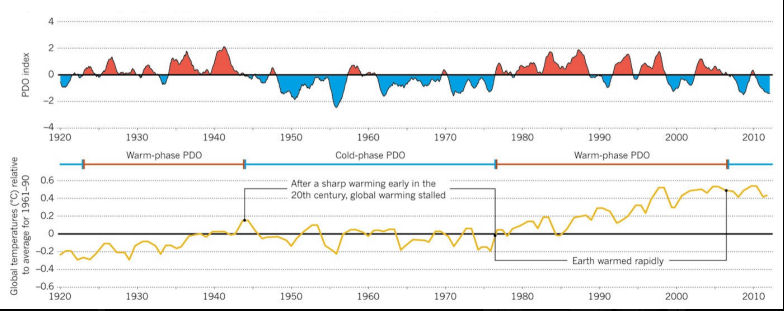

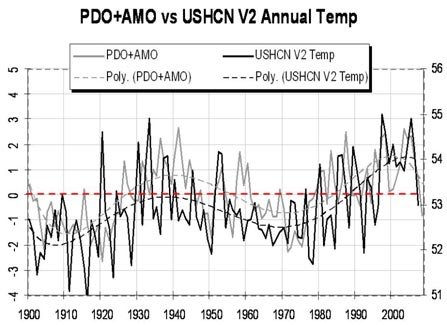

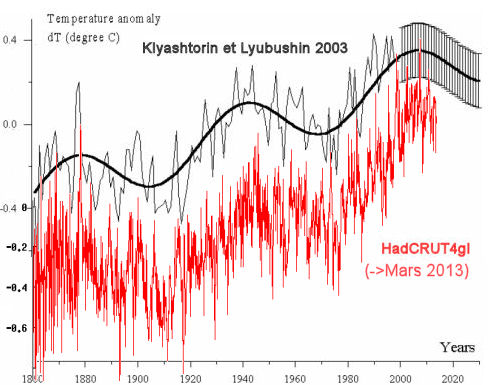

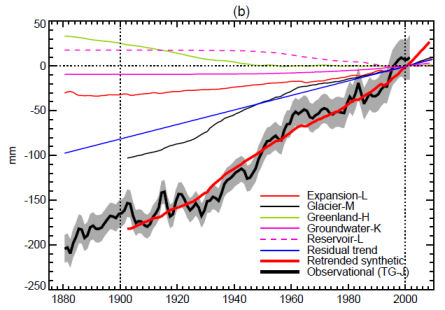

La figure ci-dessous extraite de l'article est destinée à montrer la remarquable cohérence entre le modèle GloSea5 et les observations selon les deux modes de descriptions des anomalies de l'AMOC. Elle montre que lors de la décennie précédent 2005, l'AMOC était sensiblement identique à la situation de la dernière décennie. Il y a eu une augmentation temporaire autour des années 2003-2007. D'où l'importance de replacer toujours une série de données au sein d'un contexte temporel de plus grande étendue.

| Légende : "Valeurs en fonction du temps de la force de l'AMOC. a,b, l'AMOC à 26,5°N (a) et AMOC-Ekman (b) pour l'analyse GloSea5 (en noir) et les observations du programme RAPID (en rouge). " |

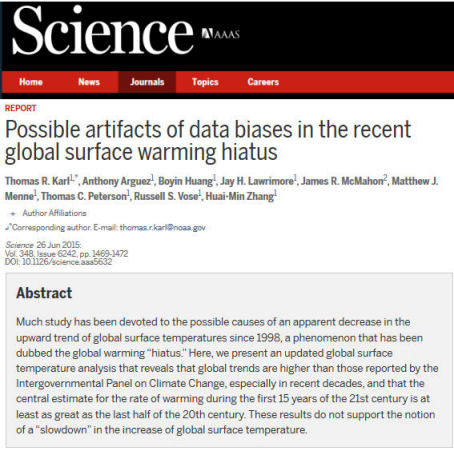

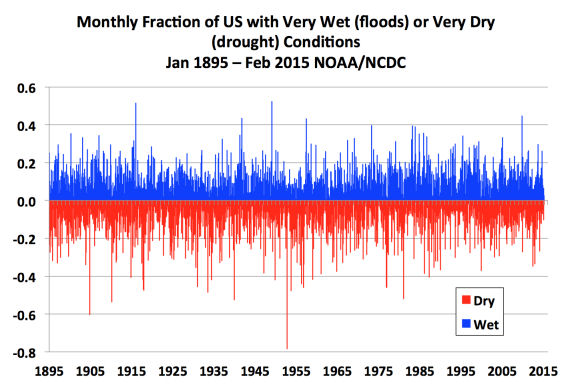

3) L'augmentation de températures a-t-elle entraîné un accroissement des précipitations extrêmes (inondations etc.) comme beaucoup l'affirment ?

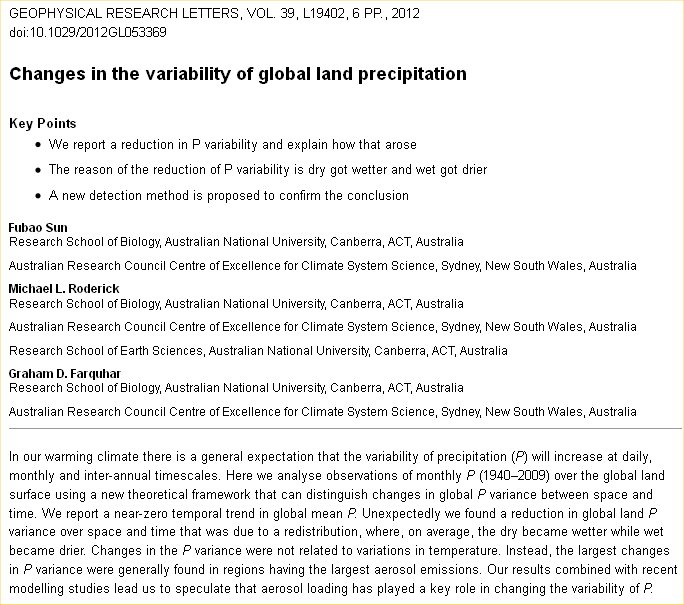

Non, répond un article publié récemment dans les Geophysical Research Letters, l'une des revues phares et très sélective de la climatologie. Voici, à gauche le fac-similé de l'entête cet article accompagné d'une traduction en français, à droite.

Source GRL

Au sujet de la dépendance des précipitations avec la température

Yu Zhou et al. (Institut Max Planck, All.)

Publié le 11 Mai 2016

Résumé :

Utilisant leur nouvelle méthode qui analyse la différence interannuelle (IADM) Liu et al. (2009) et Shiu et al. (2012) ont fait état d'un accroissement traumatisant d'environ 100%/K [NdT : soit un doublement pour une augmentation de 1°C !] des fortes précipitations avec le réchauffement de la température globale de 1979 à 2007. Une telle augmentation est alarmante et nous a incité à analyser la technique IADM.

Dans cette étude, nous montrons que, tout aussi bien, les calculs analytiques que les analyses numériques démontrent que l'IADM n'apporte pas d'information supplémentaire par rapport aux régressions linéaires conventionnelles et aussi qu'il peuvent donner une fausse indication de dépendance. C'est pourquoi, pour des raisons de simplicité, et dans un but de clarification, nous recommandons l'utilisation des régressions linéaires plutôt que l'IADM pour la détection de la dépendance.

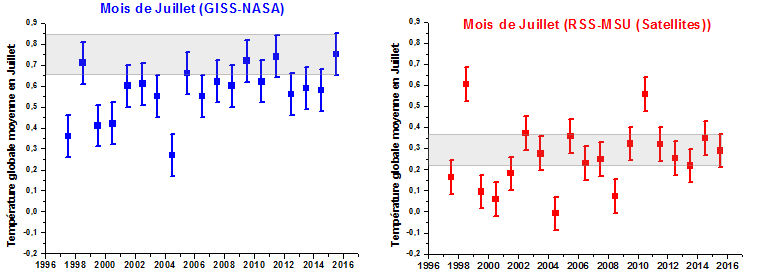

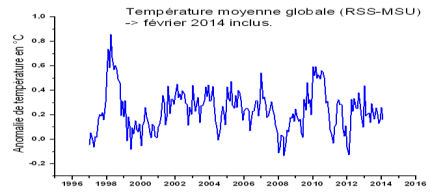

De plus, nous trouvons que les fortes précipitations ont décru durant la pause du réchauffement climatique et que la dépendance des précipitations avec la température a chuté de presque 50% quand la période d'étude est prolongée de 1979 à 2014 et qu'elle peut encore continuer à chuter dans le proche avenir. Le risque d'avoir de fortes précipitations en cas de hausse de la température globale a sans doute été surestimé. |

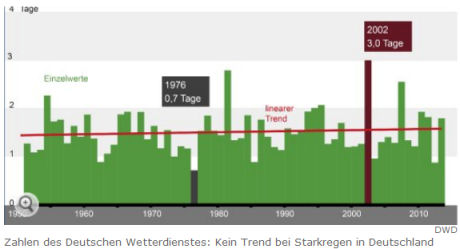

Dans le même esprit et à titre d'illustration, le journaliste scientifique du Spiegel allemand, Alex Bojanowski, démonte les déclarations ultra-alarmantes de la presse allemande au sujet des pluies et des inondations récentes en Allemagne dans cet article (repris en français ici). En réalité, les statistiques de la météo allemande (Deutsche Wetter Dienst (DWD)) ne montrent aucune tendance à la croissance des fortes pluviométries depuis 1951. Bojanowski n'hésite pas à accuser ses collègues journalistes de pratiquer ce qu'il appelle le "Klima-bluff", le "bluff climatique".

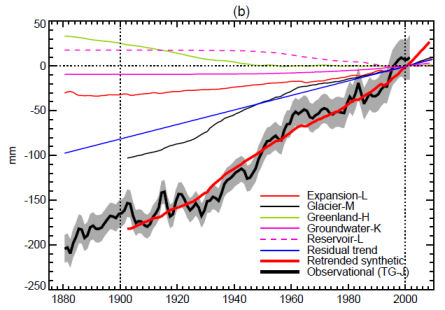

Voici le graphique qui indique la nombre de jours ayant connu des précipitations supérieures à 30 litres/mètres carrés en Allemagne, depuis 1951 jusqu'à nos jours. Comme le souligne le DWD, aucune tendance à la hausse ou à la baisse n'est observable durant cette période. En bref, les fortes pluies ne sont ni plus fréquentes ni plus durables que lors des décennies écoulées.

5) Remarques et conclusions :

Faut-il le répéter, une fois encore ?

La science progresse inéluctablement et - c'est même le propre des découvertes - elle remet fréquemment en cause ce que l'on tenait pour acquis et qui était admis au titre du fallacieux "consensus scientifique" qui est une expression qui relève de la politique mais pas de la science. Les derniers résultats obtenus par le projet CLOUD du CERN de Genève en sont une excellente illustration.

Feu Michael Crichton (Docteur en médecine et auteur à succès d'un grand nombre de fictions telles que Jurassic Park) s'était révélé particulièrement pertinent lors d'une de ses dernières conférences. Il dit :

Soyons clair : Le travail de la science n'a strictement et en aucun cas, à voir avec le consensus. Le consensus, c'est l'affaire des politiques. Au contraire, la science exige qu'un seul chercheur ait raison ce qui signifie qu'il ou qu'elle a des résultats qui sont vérifiables par rapport au monde réel. En science, le consensus est hors de propos. Ce qui est pertinent ce sont les résultats reproductibles. Les plus grands scientifiques de l'histoire le sont précisément parce qu'ils ont rompu avec le consensus.

Il n'y a rien de tel que le consensus en science. S'il y a un consensus, ce n'est pas de la science. Si c'est de la science, il n'y a pas de consensus. Un point c'est tout."

|

Pour ce qui concerne les feux de forêts, les inondations et le Gulf Stream, parmi d'autres canards, restez vigilants et conservez votre esprit critique. La quasi-totalité des gens qui vous en parlent ne lisent pas la littérature scientifique ou font l'impasse sur les articles qui les dérangent.

Stay Tuned !

|

11Mai 2016 : Observations : Encore trois bonnes nouvelles !

Comme je vous l'ai souvent fait remarquer, la science progresse lentement mais imperturbablement, bien loin de l'agitation des microcosmes politique/médiatique/militants. De fait, il ne se passe pas une semaine sans qu'une revue cotée ne publie une nouvelle étude qui remet sérieusement en question ce que l'on croyait savoir et que l'on tenait pour sûr et certain jusque là. Le problème vient du fait que nos médias n'en parlent pratiquement pas et qu'ils donnent l'impression au public et aux politiques que la science reste figée dans de nombreux domaines et qu'elle n'évolue pas.

C'est une image très éloignée de la réalité comme ce site s'efforce de le vous le montrer, avec des moyens très limités mais persévérants.

En bref, ce mois-ci, comme beaucoup d'autres, nous apporte notre lot de bonnes nouvelles qui viennent sérieusement remettre en question les discours apocalyptiques dont les médias aiment à abreuver leurs lecteurs.

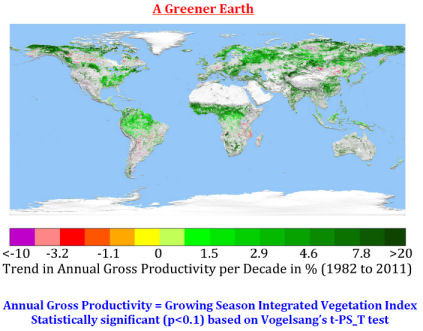

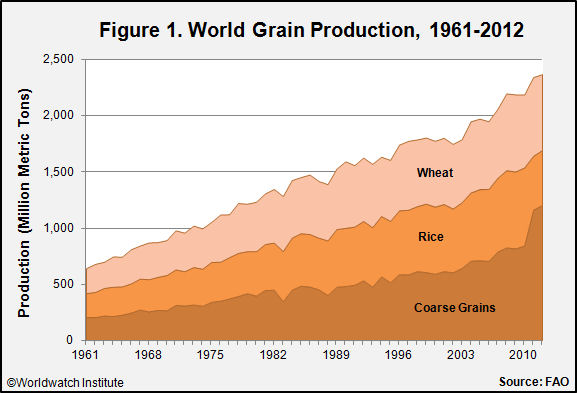

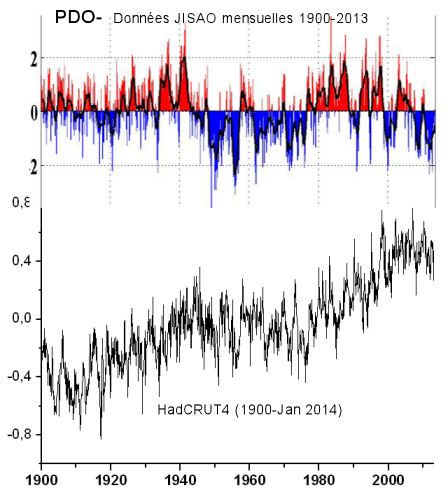

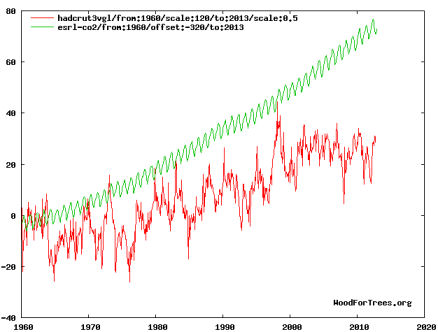

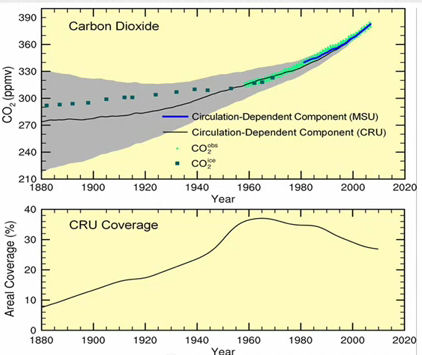

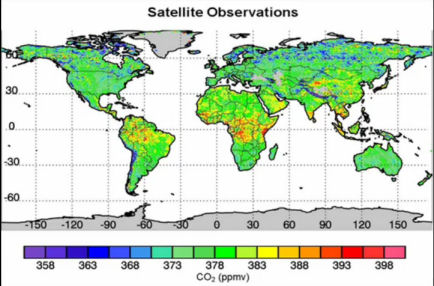

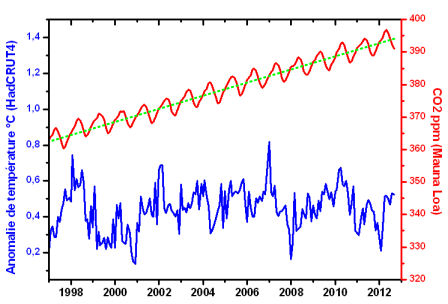

Tout d'abord nous allons voir que les observations démontrent sans ambiguïté, qu'au moins depuis le début des observations satellitaires qui datent d'une trentaine d'années, notre Terre a nettement verdi. C'est à dire, en termes plus scientifiques, que la surface foliaire totale, bien visible depuis l'espace, s'est considérablement agrandie. Pour leur part, les modélisation attribuent la majeure partie de ce verdissement à l'augmentation du taux de CO2 atmosphérique à côté d'autres causes moins importantes. C'est évidemment une très bonne nouvelle que d'observer (si on ne le savait pas déjà) que le CO2 a des effets bénéfiques sur la végétation, même si une partie de la presse s'efforce de la minimiser.

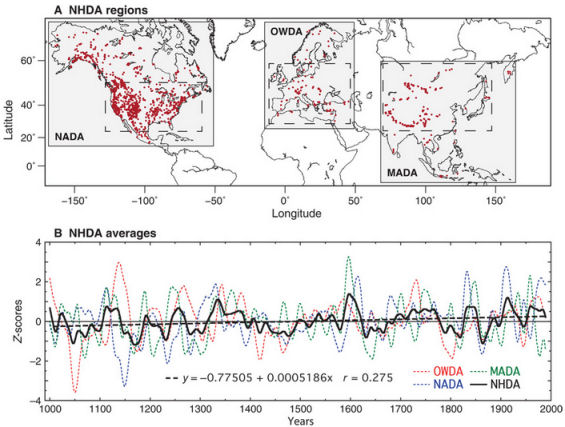

Une deuxième bonne nouvelle émerge de l'examen des épisodes pluvieux et de sécheresses inscrits dans les données géologiques depuis 12 siècles. Cette étude exhaustive montre (comme d'autres travaux) que les sécheresses et les pluies que nous connaissons de nos jours n'ont rien à envier à celles des siècles passés, ce qui va, bien entendu, totalement à l'encontre des discours assénés quotidiennement au grand public selon lesquels nous vivrions une époque climatiquement catastrophique et sans précédents.

Enfin, beaucoup s'inquiétaient du devenir des planctons qui vivent dans la partie supérieure des océans et qui risqueraient de souffrir d'un réchauffement climatique putatif. Des chercheurs britanniques ont récemment démontré que ces planctons sont entraînés par les courants marins et effectuent des périples considérables, de plusieurs milliers de km, dans les océans, ce qui leur fait naturellement subir des variations de température de quelques 10°C, sans dommage pour eux et ce qui les place hors de portée des avanies d'un futur réchauffement climatique supposé. En fait, ces organismes microscopiques sont très bien entraînées à subir de grandes variations de température au cours de leur vie.

De fait, comme on va le voir, la Nature a plus d'un tour dans son sac quand il s'agit de déjouer les pronostics les plus pessimistes ...

Dans ce billet, les caractères engraissés dans le corps des textes le sont par PU.

1) La terre verdit ... en grande partie grâce au CO2 ajouté !

La bonne nouvelle avait déjà été annoncée lors d'une conférence internationale qui s'est tenue à Avignon en 2014 comme je l'avais rapporté dans mon billet du 06 Novembre 2015 qui passait en revue les données disponibles (et franchement rassurantes) sur les "calamités et les événements climatiques extrêmes."

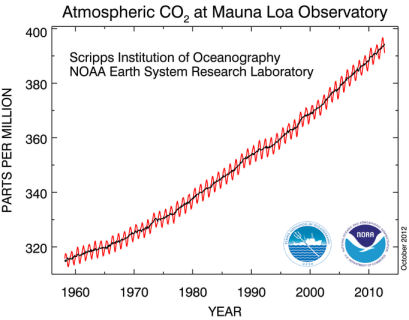

Dès 2013, le journaliste scientifique anglais, (Lord) Matt Ridley avait donné une conférence sur ce sujet dans laquelle il présentait les observations les plus récentes connues à l'époque dans lequel il attribuait (avec les scientifiques) le verdissement de la planète à l'augmentation du taux de CO2 résultant de l'usage des fluides fossiles. Il rappelait que Charles Keeling (le pionnier des mesures du taux de CO2 dans l'atmosphère, devenu une icône des tenants du réchauffement climatique) avait prévu cet effet, dès le début de ses travaux. Comme on pouvait s'y attendre, Matt Ridley avait, à l'époque, subi les foudres des nombreux détracteurs issus du microcosme politique, médiatique ou scientifiques . De fait, la suite a montré que c'est Ridley qui avait raison, comme vous allez le voir.

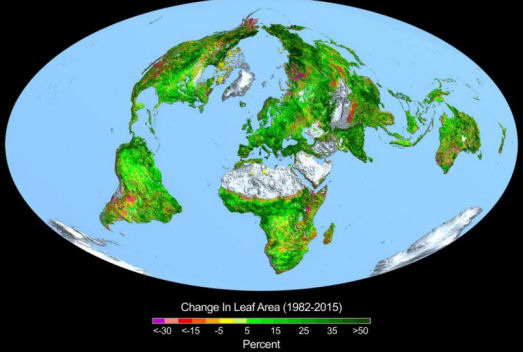

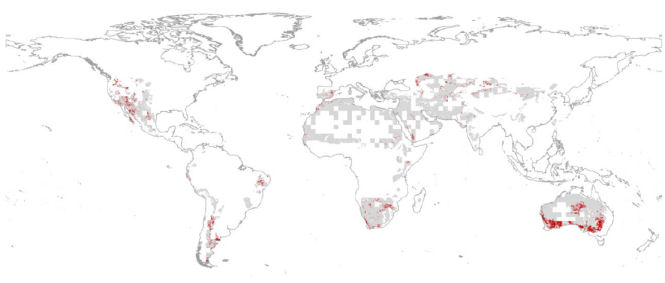

L'image ci-contre (Credits: Boston University/R. Myneni, un des auteurs de l'article présenté ci-dessous) montre, à l'aide de l'échelle des couleurs intitulée "Changement de la surface foliaire (1982-2015)", qu'à l'exception des zones sévèrement désertiques et des zones englacées, la quasi totalité de la planète à "verdi" (y compris le Sahel), c'est à dire que la surface de la couverture foliaire (forêts et végétation) a beaucoup augmenté durant les 33 dernières années. Comme il est affirmé dans l'article mentionné ci-dessous, il s'agit d'une augmentation caractérisée sur 25 à 50% de la surface du globe. Ce n'est pas un détail.

Depuis l'intervention de Matt Ridley qui, en réalité, explicitait les connaissances de l'époque, la science a progressé. Les bases de données se sont enrichies et les observations de différents satellites se sont affinées et ont été recoupées, au point qu'elles sont devenues incontestables. C'est ainsi qu'in fine, un article qui fait le point sur cette question vient de paraître dans la revue Nature (Climate Change) du 25 Avril 2016. Il est cosigné par une cohorte de 32 chercheurs relevant de 24 institutions académiques chinoise, américaine (USA), espagnole, australienne, française, allemande, anglaise et japonaise. Autrement dit, cet article est signé par le gratin des experts internationaux qui s'occupent de ces questions. On peut penser qu'il fera autorité dans ce domaine, au moins, pendant un certain temps.

Voici, ci-dessous, à gauche, un fac-simile de l'entête et du résumé de cet article, accompagné d'une traduction en français (à droite).

Nature Climate change - Lettre.

"Le verdissement de la Terre et ses causes"

Résumé : Le changement de l'environnement du globe est en train de modifier la dynamique de la végétation terrestre avec des conséquences pour le fonctionnement du système terrestre et pour l'approvisionnement des écosystèmes. Cependant, la manière dont la végétation du globe répond aux changements environnementaux n'est pas solidement établie.

Dans cet article, nous utilisons trois séries de données résultant des mesures satellitaires de longue durée qui mesurent l'indice de surface des feuilles (LAI: Leaf Area Index) ainsi que dix modèles globaux des écosystèmes de manière à étudier quatre facteurs clefs qui pilotent les tendances du LAI de 1982 à 2009.Nous montrons une augmentation persistante et largement répandue de l'indice LAI pendant la saison de croissance (verdissement) sur 25% à 50% des surfaces du globe portant une végétation tandis que moins de 4% du globe montre une décroissance du LAI (brunissement). Des simulations factorielles avec de multiples modèles écosystémiques du globe suggèrent que les effets de fertilisation par le CO2 expliquent 70% des tendances au verdissement observées, suivis par le dépôt d'azote (9%), puis par le changement climatique (8%) et par les modifications de la couverture des terres (LCC : Land Cover Change) (4%).Les effets de la fertilisation par le CO2 explique la plupart de la tendance au verdissement sous les tropiques tandis que le changement climatique a provoqué le verdissement des hautes latitudes et du plateau Tibétain. Le LCC a surtout contribué au verdissement régional observé en Chine du Sud et dans l'Est des Etats-Unis. Les effets régionaux de facteurs inexpliqués suggèrent que la prochaine génération des modèles écosystèmiques devra explorer les impacts de la démographie forestière, les différences entre les intensités de la gestion régionale des terres cultivées et des pâtures ainsi que d'autres contraintes émergentes liées à la productivité telles que la disponibilité en phosphore.

|

A noter que l'effet fertilisant du CO2 sur la croissance des végétaux est connu depuis bien longtemps. Voici, par exemple un article publié en 1920 sur ce sujet . De nos jours, les maraîchers et les horticulteurs qui cherchent à améliorer leurs rendements, imposent couramment une concentration d'environ 1000 ppm (qui semble être un optimum, soit 2,5 fois la concentration naturelle actuelle) de gaz carbonique dans leurs serres, évidemment sans dommages pour eux.

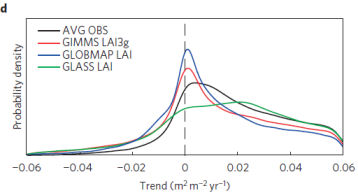

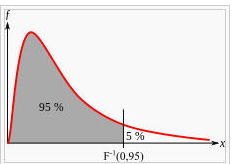

Tiré de l'article et à titre d'illustration, voici une comparaison, en terme de densité de probabilité, entre les différents modèles utilisés et la moyenne des trois observations satellitaires (AVG OBS).

Sa légende : d, Graphe de densité de probabilité des tendances des LAI pour GIMMS LAI3g, GLASS LAI, GLOBMAP LAI avec la moyenne des trois séries de mesures satellitaires (AVG OBS).

On constate, en effet, que le graphe de densité de probabilité est fortement déporté vers les valeurs des tendances positives, ce qui est une manière probabiliste d'illustrer le verdissement de la planète. Comme on le voit, ceci est valable aussi bien pour les modèles que pour les observations effectives.

On aurait pu espérer que tout le monde se serait réjoui de cette bonne nouvelle.

La terre a (re)verdi ! Quelle aubaine pour les forêts, l'agriculture, les savanes et leurs riches biotopes !

Eh bien, non. Pas du tout ! Du moins, pas partout, comme nous allons le voir.

Ci-contre, un "cartoon" de Josh que j'ai francisé et qui porte précisément sur ce sujet.

A la différence d'une partie de la presse et des médias anglophones qui ont souvent annoncé cette "bonne nouvelle", la quasi-totalité des médias francophones se sont carrément abstenus d'en informer leurs lecteurs et les rares qui l'ont fait se sont empressés d'en tirer des conclusions pessimistes, peut-être dans la crainte de "démobiliser" les lecteurs dans la lutte épique engagée contre le gaz carbonique (qui est le vecteur N°1 du cycle du carbone et de la vie sur la planète) et pour demeurer fermement dans la ligne gouvernementale de la COP21.

Tel le journal Ouest-France qui, sous la plume d'Alexiane Lerouge, relatant cette découverte, titre sans ambages : "La planète reverdit et ce n'est pas une bonne nouvelle".

Ce titre, plutôt étonnant, n'a pas manqué d'interpeler nombre de lecteurs de PU qui me l'ont fait savoir. De fait, on ne peut que s'interroger :

La planète verdit (depuis une trentaine d'années, au moins) et ce n'est une bonne nouvelle ?

La journaliste d'Ouest-France aurait-elle jugé préférable qu'elle ne verdisse pas mais qu'elle "brunisse" alors que l'on sait que les biotopes, le rendements de l'agriculture, les forêts bénéficient énormément du verdissement constaté ?

La raison de ce titre est plus ou moins justifiée par un sous-titre, quelques lignes plus loin. Selon Ouest-France et en substance : "Oui, bon, ça a reverdit mais ça ne va pas durer. ça sera pire après". Ce qui est traduit en novlangue journalistique par "Le calme avant la tempête"... Bigre !

Le pessimisme qui transpire de cette dépêche repose sur les affirmations de l'un des auteurs (un français, cité plus loin par Judith Curry) de l'article en question qui affirme que la capacité de la végétation de la planète à absorber le CO2 additionnel pourrait parvenir à saturation et qu'ainsi la végétation pourrait ne plus croître comme elle le fait depuis, au moins, une trentaine d'années, et pourrait même dépérir. Ceci, nous dit-on, résulte d'études (évidemment non précisées) qui l'affirment.

Nous avons voulu en savoir un peu plus sur cette question et nous sommes donc retournés aux sources les plus officielles (et consensuelles, dit-on) qui soient, c'est à dire vers le dernier rapport scientifique officiel du GIEC, dit l'AR5 (Assessment Report N°5) publié en 2013.

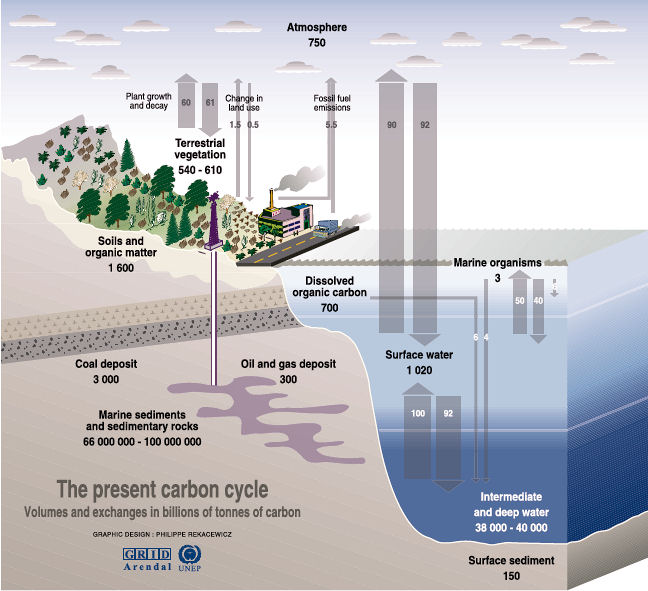

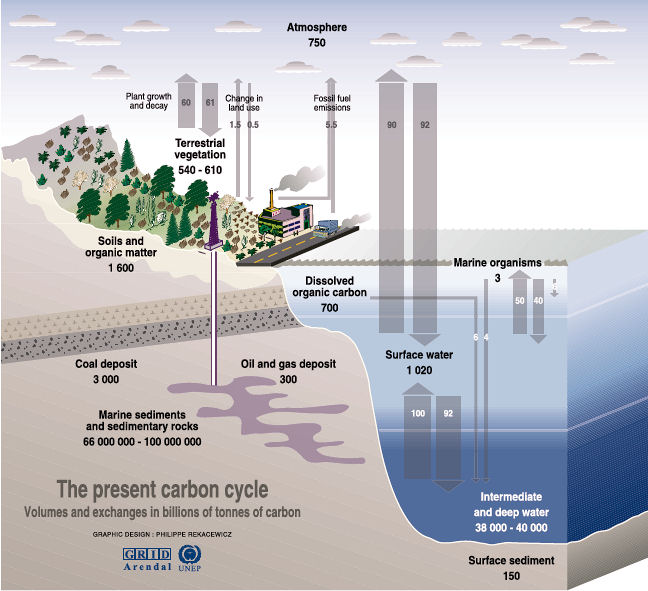

Dans ce rapport très volumineux dont la lecture est riche d'enseignements même s'il est, hélas, très peu fréquenté par les médias et les politiques, on trouve un chapitre 6 du WGI (Working Group I, les bases scientifiques) dédié au cycle du carbone.

Voici un extrait de ce chapitre qui dément frontalement les affirmations du journal Ouest-France.

AR5 (2013) WGI -Chap. 6 intitulé : Carbone et autres cycles biogéochimiques (Carbon and Other Biogeochemical Cycles)

Box 6.3 (page 502) : "L'effet fertilisant du dioxyde de carbone"

| “Depuis l'AR4 [NdT : le rapport précédent qui date de 2007], de nouveaux éléments de preuves sont devenus disponibles à partir des expériences de longues durées nommées "Enrichissement par le CO2 en air libre" (Free-air CO2 Enrichment, FACE) sur des écosystèmes tempérés qui montrent la capacité des écosystèmes exposés à des forts taux de CO2 à soutenir des taux plus élevés d'accumulation de carbone pendant de nombreuses années." |

Autrement dit, le programme FACE montre que les écosystèmes (tels les forêts, les plantes, les récoltes vivrières, etc.) sont capables de faire face à une augmentation du taux de CO2 pendant de nombreuses années. Il n'est pas question de saturation dans le texte du GIEC.

C'est aussi ce que soutenait, entre autres, un article, datant de 2011, qui analysait deux publications sur les processus au moyen desquels les végétaux s'adaptent aux taux élevés de CO2 et aux sécheresses, notamment, en réduisant leurs pertes hydriques via la réduction automatique de l'efficacité du système stomatal. Les déclarations des auteurs sur la pérennité de ces processus qui favorisent la croissance, même en zones appauvries en humidité, sont sans ambiguïté :

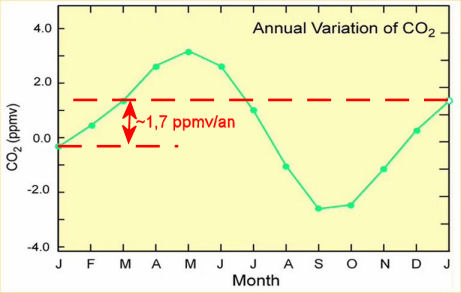

"Notre premier article montre les connexions entre la température, la transpiration et la densité des stomates" dit Dilcher. "Le second article concerne l'application de ce que nous savons pour le futur."

Ce modèle suggère qu'un doublement de la concentration de dioxyde de carbone - de 390 ppm à 800 ppm - [NdT : nous en sommes à 400 ppm] divisera par deux la quantité d'eau perdue dans l'atmosphère, ce qui permet de conclure dans le second article que "l'adaptation des plantes à l'augmentation de CO2 est actuellement en train d'altérer le cycle hydrologique et le climat et continuera à le faire tout au long de ce siècle"". |

Autrement dit, la Nature a plus d'un tour dans son sac comme nous le découvrons peu à peu et comme nous en reverrons un exemple au §3. Les plantes continueront à s'adapter tout au long du siècle y compris pour un doublement du taux de CO2 dans l'atmosphère. Nous avons le temps de voir venir et si la planète continue à reverdir au rythme où elle l'a fait durant les trois décennies passées, ce ne peut-être qu'une bonne chose. Sauf à craindre d'être contraints de vivre à un époque du type jurassique ou le taux de CO2 était quelques 2,5 fois plus élevé que maintenant et où la végétation était luxuriante au point de permettre l'alimentation et la croissance d'animaux gigantesques, les dinosaures.

Voici le point de vue de Judith Curry sur ce sujet :

"Cet article est sans doute l'étude qui fait le plus autorité sur le verdissement de la Terre que j'ai vu, bien que je sois certaine qu'il ne sera pas le dernier mot sur ce sujet. Pour ce qui est de son évaluation en terme de politique c'est à dire en essayant de faire le bilan entre les effets bénéfiques de l'accroissement de la végétation pour une population en augmentation rapide et la hausse hypothétique du niveau des mers et des événements météorologiques plus extrêmes, la réponse n'est pas du tout évidente. Il est inapproprié de rejeter les arguments des soi-disant "opposants", parce que leur désaccord avec le consensus reflète un conflit de valeurs et une préférence pour l'empirique (c'est à dire pour ce qui a été observé) par opposition à l'hypothétique (c'est à dire ce qui résulte des projections des modèles climatiques). Ces désaccords sont au coeur du débat public sur le changement climatique et ces problèmes devraient être débattus et non pas écartés.

J'ai commencé à creuser ce sujet à peu près à l'époque du procès du Minnesota au sujet du coût social du carbone en octobre dernier. A cette époque, une image non publiée dans la littérature par le co-auteur Myneni était le sujet de violentes disputes. Apparemment, ce diagramme était une version préparatoire de ceux qui sont publiés dans l'étude dont il est question ici (l'auteur principal était en postdoc chez Myneni). La version publiée montre beaucoup plus de verdissement et une beaucoup plus grande part est attribuée aux émissions anthropiques. [...]

J'ai été très irritée par cette affirmation contenue dans leur communiqué de presse :

L'aspect bénéficiaire de la fertilisation par le CO2 qui promeut la croissance des plantes, a été utilisé par les opposants, plus spécialement par Lord Ridley et Mr Ruppert Murdoch, pour argumenter contre les coupes des émissions de carbone destinées à lutter contre le changement climatique telles que celles sur lesquelles est fondé l'accord de la 21e Conférence des Parties (COP) qui s'est tenu à Paris, l'année dernière, sous la houlette de l'Organisation des Nations Unies sur le Changement Climatique (UNFCC).

Pourquoi donc, l'auteur coordinateur principal du GIEC, Philippe Ciais, éprouve-t-il le besoin de lancer cette pique à l'encontre de Ridley et Murdoch ? En particulier, il y a des années que Ridley a fait des déclarations publiques au sujet du verdissement de la planète, lesquelles ont été sévèrement critiquées à l'époque mais qui sont confortées par ce nouvel article. Il semble que Ciais soit le seul, parmi les auteurs, a faire une telle déclaration désobligeante (du moins, pour le moment). Qu'est ce qu'un auteur/militant du GIEC peut faire quand la science ne va pas dans le sens de son agenda politique ? Malheureusement, il semble que le ré-examen de leurs prémisses ne fasse pas partie de leur programme.

Cet article met en lumière les très substantielles incertitudes qui règnent sur notre compréhension quantitative du budget global en matière de carbone [NdT :cad le "cycle du carbone"]. Ce nouvel article signifie que :

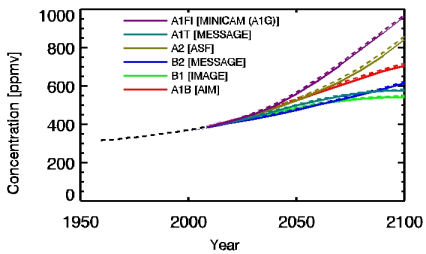

- Comme Nic Lewis le fait remarquer, cet article modifie les scénarios RCP [NdT : les modèles informatiques usuels] pour ce qui concerne le contenu résultant en CO2 de l'atmosphère. Les scénarios RCP sont significativement trop élevés.

- Cet article change la dynamique du calcul du coût social du carbone et va dans le sens de l'abaissement."

|

Dans ces conditions, on peut penser que c'est prendre une très grosse responsabilité, comme il a été fait récemment lors de la COP21, que de promouvoir la limitation drastique du taux de CO2 atmosphérique en se basant sur des résultats hypothétiques de modèles, alors que des observations directes, démontrent que le CO2 a (aussi) des effets bénéfiques manifestes sur la végétation, l'agriculture, les forêts et les biotopes. De fait, le "coût social du carbone" (comme l'on dit) a été notablement surestimé.

En effet, celui-ci n'a pris en compte que les aspects négatifs hypothétiques résultant des modèles sans prendre suffisamment en compte le très bénéfique et très considérable verdissement observé de la planète. Ce "verdissement", maintenant évident, est d'une importance cruciale, tout particulièrement en cette époque de croissance, pour quelque temps encore, de la population mondiale.

_____________________________________________

2) Une autre bonne nouvelle, et pas des moindres, également publiée dans la Revue Nature : La

pluviosité et les sécheresses récentes ne sont guère différentes de celles des siècles précédents. Il y a eu pire dans le passé.

L'article montre surtout que, dans ce domaine, les prédictions des modèles étaient erronées, ce qui jette de sérieux doutes sur leur capacité à prédire l'avenir.

Voici l'entête et le résumé de l'article sur ce sujet, paru le 6 Avril 2016 dans Nature, accompagné d'une traduction en français du titre et du résumé.

source : Nature

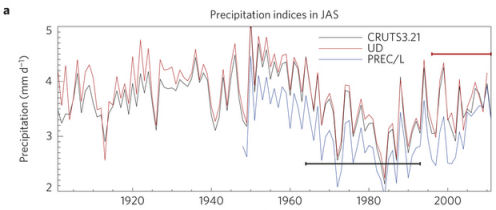

Variabilité hydroclimatique de l'Hémisphère Nord durant les 12 siècles écoulés.

Résumé : Une modélisation précise et des prédictions à l'échelle locale et à celle des continents de la réponse hydroclimatique au réchauffement climatique sont essentielles étant donné le fort impact de l'hydroclimat sur le fonctionnement des écosystèmes, sur le rendement des récoltes, sur les ressources hydriques et sur la sécurité de l'économie. Cependant, les incertitudes en matière des prédictions hydroclimatiques demeurent importantes, en partie du fait que la période pour laquelle nous disposons de données instrumentales pour tester les modèles climatiques est courte. Dans cet article nous présentons une reconstruction spatiale sur l'hémisphère Nord de la variabilité hydroclimatique durant les douze siècles écoulés, déduite d'un réseau de 196 enregistrements d'indicateurs proxy qui couvrent au moins un millénaire. Nous utilisons cette reconstruction pour replacer les récents changements hydrologiques ainsi que les scénarios pour le futur, dans le contexte à long terme des tendances hydroclimatiques résolues dans l'espace et persistantes dans le temps. Nous trouvons un pourcentage plus élevé de surface de terres avec des conditions relativement plus humides du IXe au XIe siècle et au XXe siècle tandis que les conditions sèches sont plus répandues entre le XIIe et le XIXe siècle.

Notre reconstruction révèle que des cycles marqués en dents de scie, d'humidité alternée observés dans les données instrumentales, dans la zone méditerranéenne, dans l'Ouest des USA et en Chine, ont été en action de manière persistante durant les douze siècles écoulés. A partir d'une compilation actualisée des températures de 128 indicateurs proxy, nous précisons la relation entre l'hydroclimat de l'hémisphère Nord reconstruit à l'échelle centennale avec la variabilité de la température. Même si des conditions humides et sèches se sont produites sur de vastes étendues dans des conditions climatiques, tout aussi bien, froides que chaudes, une covariabilité statistiquement significative entre l'hydroclimat et la température est évidente pour des régions spécifiques. Nous comparons les anomalies hydroclimatiques reconstruites avec les simulations des modèles généraux de circulation impliquant le couplage océan-atmosphère et nous trouvons un accord raisonnable pour l'époque pré industrielle. Cependant, l'intensification des anomalies hydroclimatiques, par comparaison avec les siècles précédents, simulée pour le XXe siècle n'est pas confirmée par notre nouvelle reconstruction multi-indicateurs. Ces résultats suggèrent qu'il reste beaucoup de travail à effectuer avant que nous ne soyons capables de modéliser la variabilité hydroclimatique avec certitude et ils mettent en lumière l'importance des données paléoclimatiques pour pouvoir situer les changements hydroclimatiques récents et prédits dans un contexte millénaire. . |

Le résumé est un peu touffu mais la fin de la conclusion de l'article est claire. En voici une traduction :

"Il y a plusieurs explications possibles pour expliquer la capacité médiocre des modèles climatiques à simuler la variabilité hydroclimatique correctement : Des gaps dans la connaissance des processus physiques qui décrivent les phénomènes qui définissent les paramétrisations des modèles des éléments de la grille qui servent pour le calcul, des biais systématiques dans les valeurs absolues des températures dans les modèles qui affectent l'évaporation et les processus de précipitation ainsi qu'une sous-estimation de la variabilité hydroclimatique interne. Nous ne trouvons qu'un accord médiocre à l'échelle régionale entre les reconstructions et les modèles comme on s'y attendrait si la variabilité hydroclimatique de l'hémisphère Nord était davantage pilotée par sa dynamique interne plutôt que par un forçage externe [NdT : ici externe = anthropique]

Notre comparaison des caractéristiques des distribution et de l'évolution temporelle des hydroclimats aux grandes échelles de temps, reconstruites et simulées aux échelles centennales, montrent de fortes similarités jusqu'au 19e siècle.

Cependant, les informations apportées par les indicateurs proxy ne vont pas dans le sens des tendances trouvées par les simulations selon lesquelles les régions humides seront plus humides et selon lesquelles les régions plus sèches le seront davantage, dans un climat plus chaud. De plus, nos reconstructions des hydroclimats ne confirment pas la tendance vers une intensification générale et sans précédent du cycle hydrologique durant le vingtième siècle associé avec des conditions plus extrêmes pour les anomalies sèches comme humides, durant le présent réchauffement climatique comme cela est simulé par un ensemble de modèles.

Nos résultats sont conformes aux analyses récentes qui résultent des observations instrumentales et qui montrent des évidences médiocres pour ce qui est de l'intensification des anomalies sèches et humides durant le présent réchauffement climatique.

L'absence d'évidence pour la réponse hydroclimatique prévue par les modèles en présence de températures plus élevées suggère que, soit le réchauffement du XXe siècle n'a pas été assez intense pour que cette signature émerge, soit que les éléments déclencheurs pour ces mécanismes doivent être ré-examinés.

Nous concluons qu'une perspective à l'échelle du millénaire telle que celle qui est procurée par les analyses multi-indicateurs, est cruciale pour servir de banc d'essai et pour évaluer les performances des simulations hydroclimatiques avec précision." |

Parmi d'autres, cet article, relativement exhaustif, et basé sur les observations effectives, dément donc frontalement, et une fois de plus, les affirmations fantasmatiques selon lesquelles : "Le sec sera plus sec et l'humide plus humide" que nous avons entendues répétées à satiété par nos ministres, nos édiles et nos journalistes qui se sont notamment apitoyés sur le futur climat africain, en particulier lors de la COP21.

Pour cette fois, et hormis quelques envolées stylistiques inappropriées et des erreurs factuelles traditionnelles chez cette agence de presse, une dépêche (en anglais) de l'AFP résume (presque) correctement la situation. De fait, son intérêt réside essentiellement dans le fait qu'elle rapporte les propos du ou des scientifiques impliqués dans cette étude. On retrouve, quoique dans une moindre mesure, les mêmes biais dans la dépêche de Reuters ("Les données climatiques depuis les Vikings jettent un doute sur les extrêmes plus humides, plus secs").

A ce propos, il est instructif (amusant) de comparer les versions dans les deux langues (anglais et français) de la même dépêche AFP qui traite de cet article. On constate immédiatement que la version française est - disons - soigneusement "édulcorée" dans les sens de l'actuel politiquement correct (chez l'organisateur de la COP21 ?).

Par exemple, la version américaine de cette dépêche AFP annonce sans ambages que :

"Predictions of unprecedented rainfall extremes in the 20th century driven by global warming turned out wrong"

| "Les prédictions de pluies extrêmes et sans précédent, résultant du réchauffement climatique durant le 20e siècle, se sont révélées fausses" |

Ce qui est clair et net mais qui devient, dans la version euphémisée destinée aux médias francophones :

| "Les modèles de prévision annonçant des précipitations sans précédent au XXe siècle du fait du réchauffement climatique étaient partiellement défectueux" |

Voici donc une traduction du texte anglais, non expurgé à destination du public francophone, de l'AFP :

"Les prédictions de pluies extrêmes et sans précédent, résultant du réchauffement climatique, durant le 20e siècle, se sont révélés fausses, selon une étude parue mercredi. Ceci jette un doute sur les méthodes utilisées pour la projection des tendances pour le futur. Une collecte massive des données pluviométriques pour les 1200 années passées, montre qu'il y a eu des épisodes plus dramatiques d'événements secs/pluvieux durant les siècles plus froids avant que les hommes installent le réchauffement climatique piloté par les fluides fossiles.

Ceci pose un problème, nous dit une étude parue dans la revue Nature, parce que ce sont les mêmes modèles qui sont utilisés pour prédire des extrêmes records de pluviométrie des années 19xx qui sont à la base des projections pour les années à venir. "Cela pourrait être plus difficile de prédire le futur que nous le supposions" a déclaré l'auteur principal de l'étude, Fredrik Ljungvist de l'Université de Stockholm, à l'AFP au sujet de ces résultats.

“La vérité peut être plus - beaucoup plus - compliquée".

Le Comité sur la Science du Climat de l'ONU qui fait autorité en matière de consensus [NdT : cad le GIEC], soutient que les régions sèches le seront encore plus et que les zones humides le seront davantage du fait de la hausse des températures en réponse aux émissions de gaz à effet de serre [NdT : Faux ! Le dernier rapport scientifique complet du GIEC, l'AR5 (2013), ne dit pas cela. Il dit qu'il ne se prononce pas sur ces questions et que la confiance dans les prédictions est faible ou très faible. En l'occurence, l'AR5 avait raison. Par contre, le rapport précédent (l'AR4 de 2007) soutenait cette idée qui a été très sérieusement recadrée dans le plus récent rapport, l'AR5. Il serait sans doute souhaitable que le personnel de l'AFP s'informe un minimum, avant de rédiger ses dépêches.]

Mais ce nouveau travail nous dit que les températures très élevées [Ndt : "Sky-high" (!) dans le texte en anglais] durant le XXe siècle n'ont pas directement résulté dans des extrêmes climatiques en matière de temps humide et sec comme beaucoup l'avaient attendu. Ceci signifie qu' "une grande partie du changement n'est pas seulement piloté par la température mais par une variabilité interne, plus aléatoire", a expliqué Ljungqvist.

“De ce fait, il est très, très difficile de prédire aussi (les extrêmes en terme de précipitations) avec des modèles"

Durant la période de temps couverte par cette étude, les sécheresses étaient plus sévères durant le XIIe siècle qui était un siècle chaud et durant le XVe qui était froid, a déclaré le scientifique. Pour cette étude, une équipe d'experts en histoire, en climat, en géologie et en mathématiques a compilé les données au sujet des sécheresses et des pluies pour l'Europe, le Nord de l'Asie et de l'Amérique, pour reconstruire 12 siècles d'"histoire de l'eau".Ils ont pris en compte les évidences des flux des rivières, du niveaux des lacs, des sédiments marins et lacustres conservés par la géologie ainsi que les cernes des arbres et les relevés historiques.

La reconstruction par l'équipe pour le XXe siècle diffère considérablement [NdT : "The team’s reconstruction for the 20th century differed vastly from climate models" en anglais, ce qui est assez différent de la version française édulcorée qui trouve que les modèles ne sont que "partiellement défectueux".] des modèles climatiques qui avaient suggéré que les zones humides auraient dû l'être encore plus et que les sèches auraient dû l'être davantage que jamais auparavant. "Dans le passé, sur une échelle de temps plus longue, il y a eu des variabilités encore plus importantes", dit Ljungqvist. [...]" |

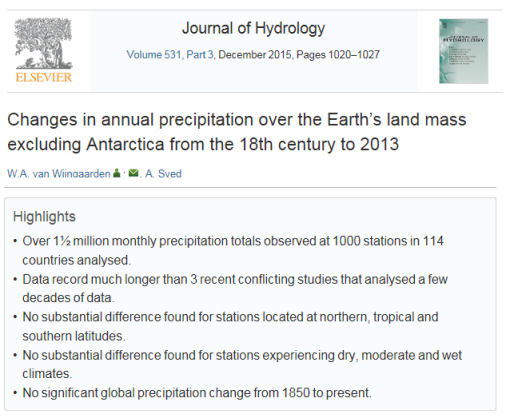

A noter également qu'une autre étude extensive parue récemment (Nov 2015) dans le Journal of Hydrology qui porte sur la pluviosité sur le globe du XVIIIe siècle à 2013 (antarctique exclus) ne montre aucune variation significative dans les tendances des pluies durant cette période. (article en accès libre).

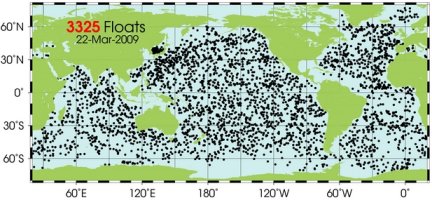

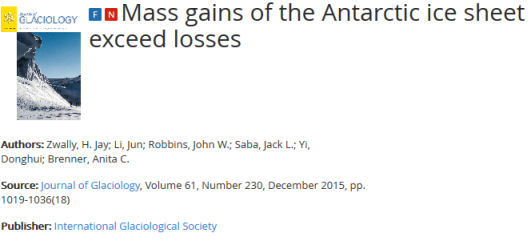

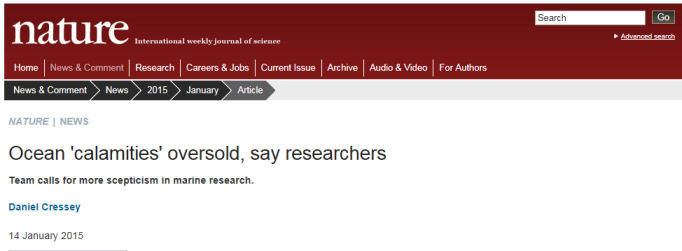

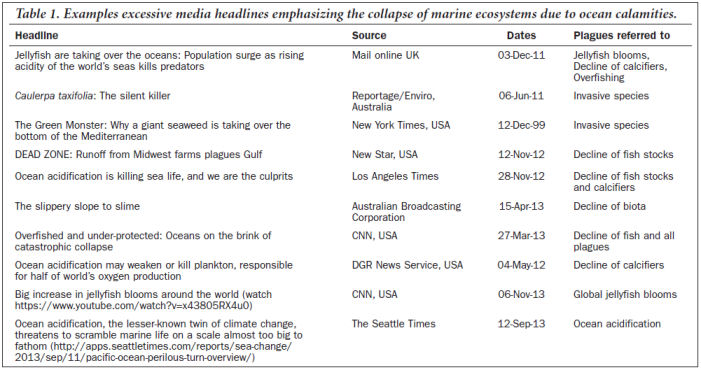

3) Et enfin, une troisième bonne nouvelle : Les planctons sont entraînés à survivre à des variations de température considérables durant leurs périples à travers les océans du globe. Ils ne souffriront pas du réchauffement climatique, contrairement à ce que l'on craignait auparavant.

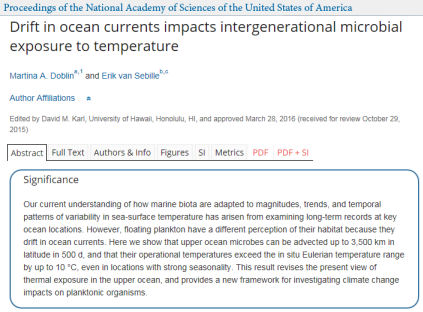

Cette conclusion résulte des travaux de recherche publiés, le 26 Avril 2016, dans la revue (réputée) PNAS, les Proceedings of the National Academy of Science (US).

En bref, jusqu'à présent, et c'est le point de vue qui était reflété dans le dernier rapport du GIEC (l'AR5 de 2013), on pensait qu'il suffisait d'étudier l'influence de la température sur les planctons océaniques situés dans des endroits déterminés, fixes et bien choisis. Les conclusions étaient pessimistes sur l'avenir des planctons dans le cadre d'un réchauffement supposé à venir.

On sait les variations de température significatives se produisent essentiellement en surface où demeurent les planctons dont la survie pouvaient être remise en cause par la réchauffement climatique. Ceci pourrait avoir, à l'évidence, des conséquences dramatiques pour les biotas marins dont ils constituent une part essentielle de l'alimentation.

C'était oublier que de puissants courants marins animent constamment la surface des océans et entraînent, dans leurs périples, les planctons qui subissent ainsi des amplitudes thermiques considérable au cours de leur vie et de leur reproduction. Les chercheurs, auteurs de l'article suivant, ont montré que les planctons pouvaient affronter ainsi, sans dommage et au cours de leurs périples, des variations de températures de 10°C ce qui les place hors de portée des avanies d'un hypothétique réchauffement climatique à venir.

On constate donc que les planctons de surface qui sont les plus menacés, sont hyper-résistants. Beaucoup plus qu'on ne le croyait auparavant.

En bref, on voit que la Nature a plus d'un tour dans son sac pour déjouer les analyses les plus pessimistes des chercheurs rédacteurs du rapport du GIEC.

Voici l'entête de l'article et une traduction en français :

Les courants océaniques dérivants impactent l'exposition intergénérationnelle des organismes microbiens à la température.

| Signification : Nos compréhension actuelle de la façon dont les biota marins sont adaptés à l'amplitude, au tendances et aux variations temporelles de la température de surface des océans, a résulté de l'examen de données à long terme en des endroits choisis des océans. Cependant, les planctons flottants ont une perception différente de leur habitat parce qu'ils dérivent au sein des courants océaniques. Dans cet article, tous les microbes océaniques qui résident dans la partie supérieure des océans peuvent être convoyés sur 3500 km en 500 jours et leurs températures opérationnelles dépassent les domaines de températures eulériennes in situ de valeurs atteignant 10°C, même dans des endroits qui ont une grande saisonnalité. Ce résultat remet en question le point de vue actuel sur l'exposition thermique dans la partie supérieure des océans et procure un nouveau cadre pour l'étude des impacts du changement climatique sur les organismes planctoniques. |

Le résumé n'est guère transparent mais le communiqué de presse l'est. Le voici :

Communiqué de presse.

"Les planctons ont évolué de manière à survivre à une grande gamme de conditions et ceci grâce à leurs vastes et inattendus périples à travers les océans. C'est ce que suggère une nouvelle étude.

Ces organismes microscopique sont essentiels dans le réseau de l'alimentation marine. Ils procurent l'alimentation aux baleines, aux poissons et aux crustacés. Des scientifiques de l'UTS et de l'Imperial College of London au Royaume Uni ont modélisé la manière dont le plancton dérive dans les océans de manière à savoir dans quelle mesure ils sont menacés par le réchauffement des océans.

Les résultats de cette étude, publiés dans le journal Proceedings of the National Academy of Science (PNAS), montrent, pour la première fois, l'étendue du domaine de température que les planctons subissent durant leur parcours. Dans la plupart des endroits, ils endurent des extrêmes de température qui vont bien au delà de ce qui est prédit par les modèles du réchauffement climatique.

Les scientifiques ont utilisé un modèle de circulation océanique global qui simule les trajets de trois millions de planctons virtuels ainsi que les conditions thermiques qu'ils rencontrent.

Ils ont trouvé que les courants de surface peuvent transporter des particules dérivantes jusqu'à des distances de 3500 km en 500 jours ce qui est à peu près l'équivalent d'une personne qui irait, en ramant, de la Californie à Hawaï. Durant ce périple, elles sont soumis à des variations de température qui atteignent 10°C de plus que s'ils étaient restés, immobiles, au même endroit.

"Les expositions passées à des fluctuations de température peuvent influer sur la manière dont les populations de planctons réagissent quand elles seront exposées aux futurs changements climatiques" a déclaré l'auteur principal, le professeur associé Martina Doblin qui dirige le Productive Coasts research program au sein du groupement sur le climat de l'UTS (C3). "Nos résultats suggèrent que les effets du changement climatique sur les planctons océaniques devront être ré-évalués pour prendre en compte ces observations." |

4) Que peut-on en conclure ?

Que la science progresse. Lentement mais sûrement. Imperturbablement, elle remet constamment en cause ce qui était tenu pour acquis ("setlled", disent-ils). il en va ainsi de la science en général et pas seulement de la science climatique. Il faudra bien que les médias/politiques/militants se fassent à cette idée.

On observe par exemple que les vieilles antiennes selon lesquelles "le sec sera plus sec et l'humide le sera davantage" répétées à l'envi par nos politiques et nos médias ont encore mordu la poussière, accablées par les évidences scientifiques qui se multiplient. Si on est optimiste, on peut rêver qu'un jour, dans le futur, nos édiles et nos médias s'informeront correctement, ne serait-ce qu'en lisant les plus récents rapports scientifiques du GIEC...à défaut de suivre les publications scientifiques.

A noter que les trois article présentés ici insistent, dans leur conclusions, sur la nécessité d'impliquer les résultats de leurs études dans les prochaines évaluations telles celles du GIEC. Et il ne s'agit pas de détails. très loin de là. Il s'agit même, dans certains cas, d'une remise en cause profonde des modèles en vigueur.

Ceci montre, à l'évidence, que la science du climat "is not settled", n'est pas (encore) établie, contrairement à ce que beaucoup (politiques, médias, certains chercheurs) croient ou cherchent à vous (nous) faire croire.

En aparté, vous observerez qu'aucun des auteurs des articles scientifiques - et c'est également vrai pour les autres articles scientifiques que j'ai eu l'occasion de vous présenter ou d'examiner - ne déclare "croire" ou "ne pas croire dans le réchauffement climatique anthropique", ce qui n'a d'ailleurs aucun sens. C'est la question de l'amplitude des diverses causes possibles et des conséquences envisageables qui reste posée et qui mérite (et reçoit) des réponses non binaires et argumentées. Les auteurs des articles qui paraissent dans la littérature, se limitent, pour une grande majorité d'entre eux, à chercher à comparer les prédictions des modélisation effectuées par les ordinateurs avec la réalité observée et d'en tirer des conclusions sur la nécessité de revoir les modèles ou de tenir compte de facteurs autrefois ignorés, comme c'est, par exemple, le cas pour l'article ci-dessus.

C'est pour cette raison qu'il est absurde (voire peu honnête) que d'essayer d'évaluer, à partir de ces mêmes articles, la proportion de ceux "qui croient" et de ceux "qui ne croient pas", au réchauffement climatique anthropique" comme l'a fait récemment une célèbre "étude" (abondamment citée par les médias/politiques/militants), - ici examinée en détail par Richard Tol, un spécialiste de la question - proclamant que 97% des articles scientifiques portant sur ces sujets "croient au réchauffement climatique anthropique".

Il faut s'y résoudre : L'objectif de ces scientifiques n'est pas de "croire" ou de ne "pas croire"en une théorie en vigueur. Il est de discerner ce qui colle ou ne colle pas avec les modèles issus d'une théorie et de détecter et de signaler les paramètres fondamentaux dont on a pu sous-estimer l'importance et, éventuellement, de suggérer des remises en cause et des révisions. C'est ce qu'ils font, jour après jour.

Stay Tuned ! |

10/04/2016 : Science et politique : Trois témoignages d'experts sur les recettes pour un désastre.

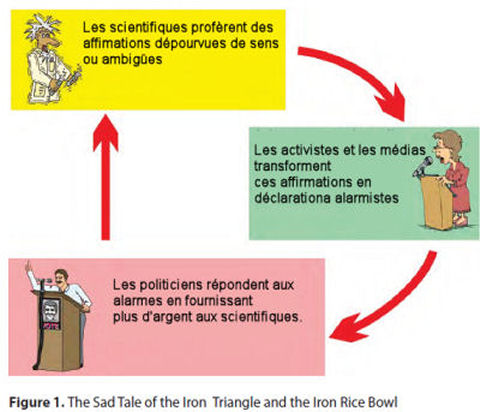

Ce mois-ci, je me propose d'aborder un sujet qui me tient particulièrement à coeur ainsi, sans aucun doute, qu'à celui de nombreux autres scientifiques. De fait, les dangers d'un pilotage de la recherche par la politique sont aussi réels que redoutables, exactement comme nous en avait prévenu Le Président Eisenhower lors de son discours d'adieu cité par Richard Lindzen dans le billet du mois dernier. Eisenhower nous avertissait, dès 1961, que :

"La possibilité d'une domination des scientifiques de la nation via l'emploi fédéral, les attributions de crédits et la puissance de l'argent est toujours présente - et doit être envisagée avec gravité".

Parmi beaucoup d'autres, deux experts européens reconnus en matière de relations entre la science et la politique se sont récemment exprimés sur ce sujet. Pour sa part, la climatologue Judith Curry n'a pas manqué d'aborder cette question cruciale lors d'un tout récent témoignage auprès du Sénat US. C'est ce que nous allons voir dans les lignes qui suivent.

1) Deux experts en relations entre la science et la politique s'expriment au sujet de la COP21 et des relations science-politique lors d'un mini-symposium européen.

Leurs déclarations sont publiées dans l'EJRR (Le journal Européen de Gestion des Risques). Les deux auteurs ne critiquent pas la science climatique en tant que telle mais relèvent, tous deux que, dans le cas de la question climatique, l'association science-politique conduit à une démarche catastrophique. Judith Curry a sélectionné les extraits les plus significatifs de leurs articles que je vous traduis (*) ci-dessous. Dans cette section, les caractères engraissés le sont par Curry.

A) Lucas Bergkamp

Lucas Bergkamp (Bio) est un docteur en médecine et juriste (docteur d'Etat, PhD) des Pays-Bas. Il est l'auteur de nombreux livres et articles au sujet des relation science/société/politique. Il siège dans une quantité de comités (notamment européens) en tant qu'expert dans ces matières.

Dans un des articles de Bergkamp, référencés sur son blog, on trouve le dessin explicite ci-contre (que j'ai francisé) qui fait allusion au débat entre les inquisiteurs et Galilée.

Voici l'entête de son article au EJRR.

"Mini-symposium au sujet de l'Accord de Paris sur le changement climatique : Une perspective dans la gestion des risques."

[...]"L'Accord de Paris sur le Changement Climatique qui a été conclus lors de la COP21 en Décembre 2015 a été qualifié de "Plus grand succès diplomatique" et de "réussite historique" mais aussi d'"échec dramatique" et même de "fraude" et de "discours sans intérêt". Déçu par l'Accord de Paris, un groupe de onze scientifiques ont signé une déclaration qui affirme que cet Accord souffrent de "défauts mortels" et qu'il donne de "faux espoirs". Ils déclarent que le temps pour les "voeux pieux et l'optimisme aveugle" est terminé et que le "spectre le plus large des possibilités de la géo-ingénierie" [NdT : c'est à dire de l'intervention délibérée sur le climat de la planète par divers procédés] devrait être envisagé.

Le désaccord largement répandu au sujet des résultats de la COP21 à Paris (en particulier pour ce qui concerne l'aspect contraignant) illustre non seulement les attentes divergentes des groupes d'intérêt, mais aussi les antagonismes qui se dressent dans tous les aspects de la mise en oeuvre des politiques entre les dogmatiques et les pragmatique, entre les idéalistes et les réalistes et entre les internationalistes et les nationalistes.

Vu de manière objective, l'accord de Paris n'apparaîtrait guère plus que comme un cadre de procédure pour la mise en place par les parties d'une future politique climatique flexible qui va de la base au sommet, habillé dans un langage non contraignant qui insiste sur les ambitions et les progressions. De manière à satisfaire le désir du gouvernement US d'éviter l'approbation par le Sénat, l'Accord n'impose aucune obligation contraignante substantielle mais il met en avant l'objectif ambitieux de limiter la température moyenne de la planète à bien moins que 2°C ou même à 1,5°C. En d'autres termes, le texte qui est ressorti de l'Accord de Paris, constitue un exemple de plus d'un accord délibérément basé sur une cible et avec des réalisations dont les résultats sont difficiles à prédire.

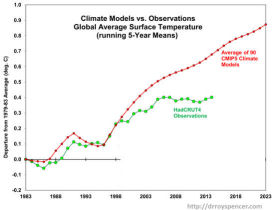

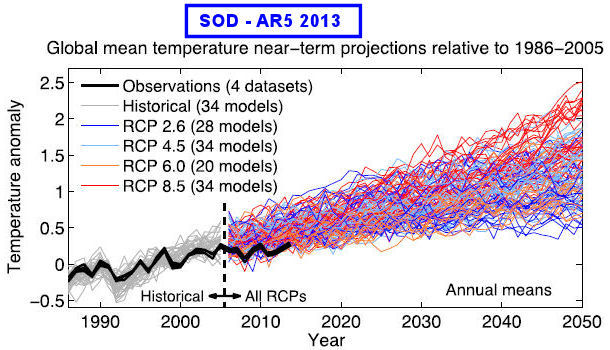

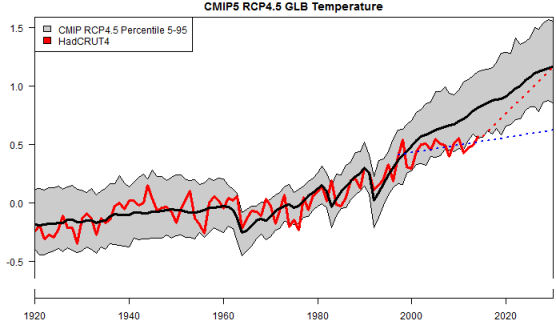

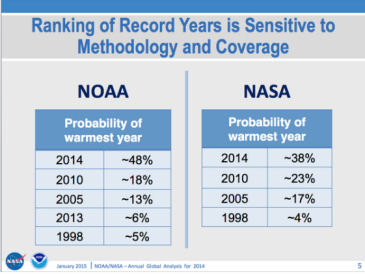

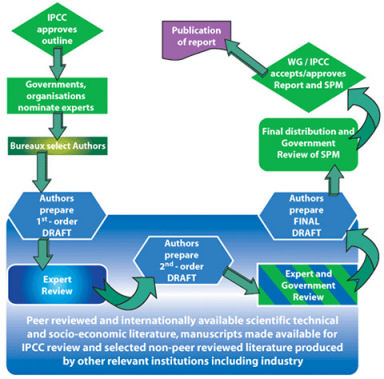

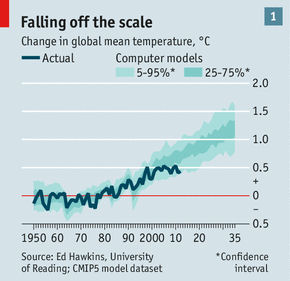

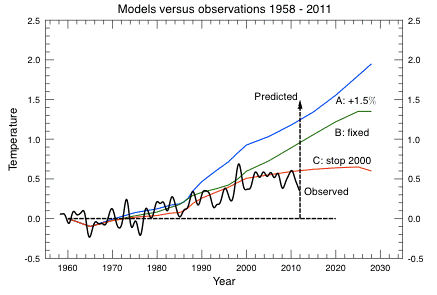

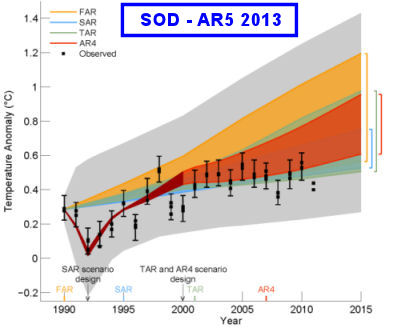

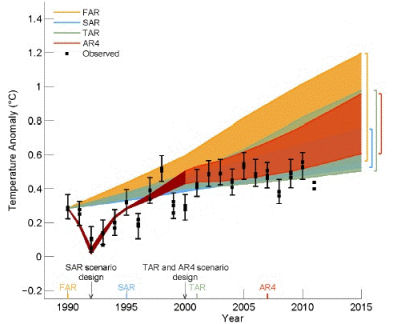

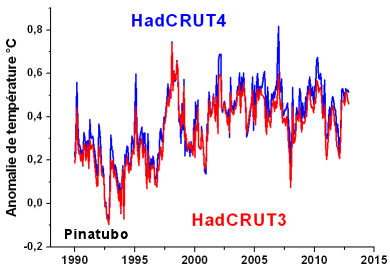

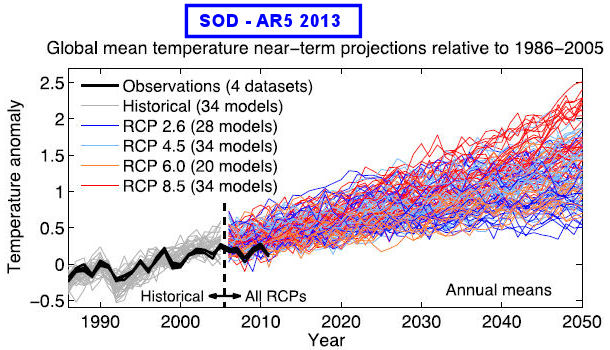

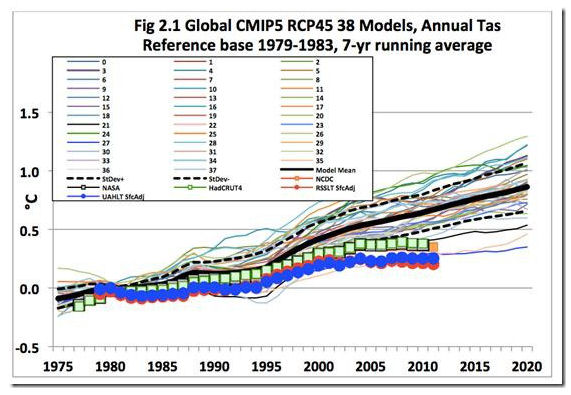

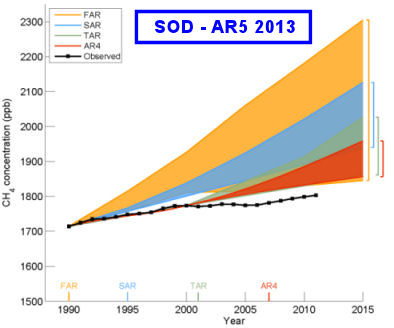

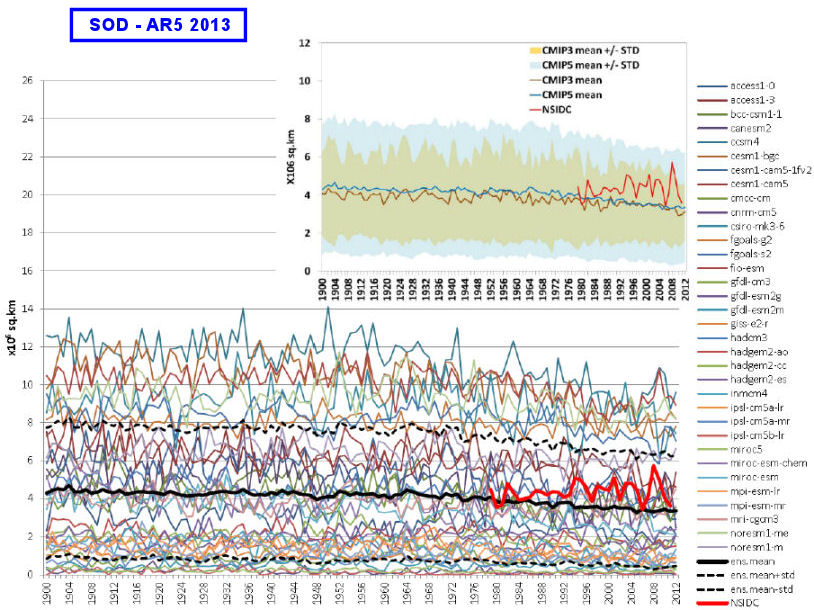

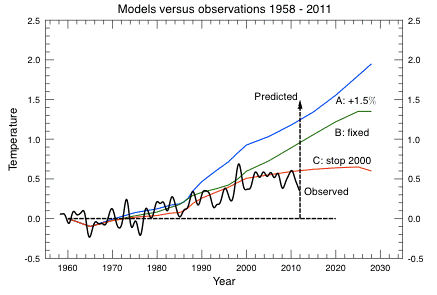

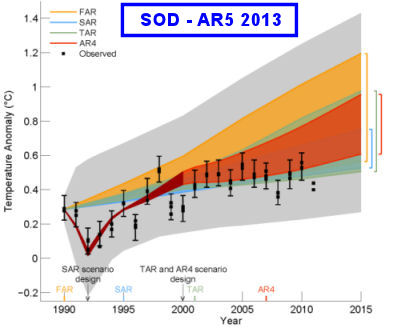

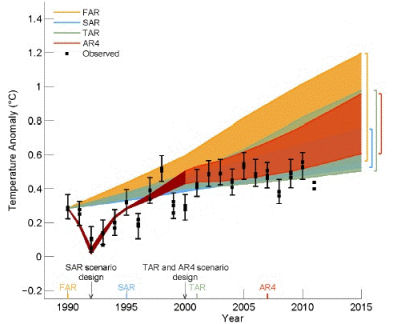

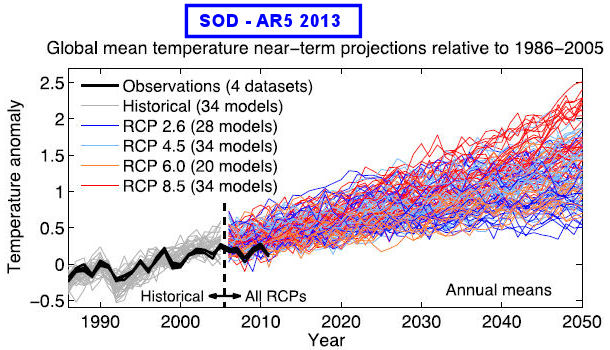

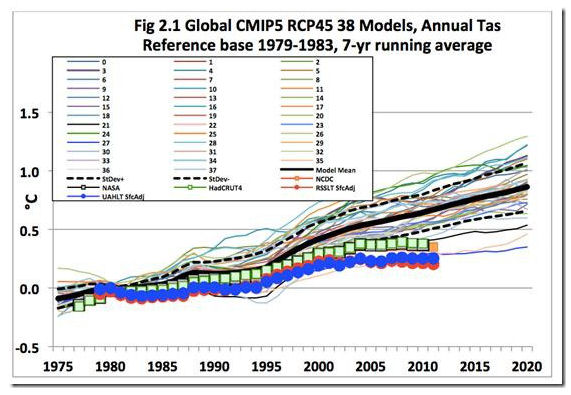

La thèse principale de cet essai va au delà du rejet de l'affirmation que "la science est comprise " qui est, de toute manière, une affirmation dont les termes sont contradictoires. Cela postule qu'il existe une tendance "scientiste" en matière de climatologie selon laquelle on croit que le climat, dans son ensemble, peut être expliqué et contrôlé en se référant à un seul paramètre. Une telle tendance scientiste se manifeste dans les modèles climatiques qui assujettissent toutes les politiques aux projections numériques plutôt qu'aux connaissances acquises par l'observation empirique. Bien que les auteurs reconnaissent que les modèles constituent une méthode utile et acceptée dans de nombreux domaines de la science, le problème clef pour les modèles du climat est de savoir s'ils satisfont à la rigueur des "tests" pour ce qui relève de la conformité de leurs prédictions (ou projections) avec les observations ou encore, avec les exigences plus softs de tests tels que ceux dits "adaptés pour le but poursuivi".